La última obra maestra de animación…

Fotograma del clip

Este corto, en concreto, es un videoclip que el artista creó para el tema «Have you seen my sister Evelyn” de la banda independiente Evelyn Evelyn, un dúo musical (con toques humorísticos) formado por Amanda Palmer y Jason Webley. La pareja interpreta en el escenario a dos hermanas siamesas (Evelyn y Evelyn Neville) que tocan un mismo instrumento al tiempo mientras cantan las letras a coro.

La calidad del videoclip es simplemente impresionante. Dibujos de aspecto similar a las primeras animaciones de Disney de los años treinta y cuarenta americanos se deslizan por el vaho de los cristales empañados de unas antiguas ventanas de madera. La música del tema recuerda muy mucho a aquellos tiempos, pues tiene un agradable tufillo a las Andrew Sisters más auténticas y genuinas del Mineápolis de la Segunda Guerra Mundial.

Sin más, os dejo con esta gran obra maestra. Sólo queda disfrutarla.

Videoclip de Evelyn Evelyn

Cómo se autodestruye un JPG

Pérdida de calidad sucesiva

El algoritmo de compresión JPEG se basa en dos defectos visuales del ojo humano. El primero de ellos es el hecho de que nuestro ojo es mucho más sensible al cambio en la luminancia que al de la crominancia, es decir, que capta más claramente los cambios de brillo que de color. El segundo se refiere a que percibimos con más facilidad pequeños cambios de brillo en zonas homogéneas que en áreas donde la variación es grande, por ejemplo en los bordes de los cuerpos de los objetos.

No es raro que los métodos de compresión con pérdida utilicen deficiencias en los sentidos del ser humano. Por ejemplo, el archiconocido formato de compresión de sonido MP3 se sirve de las imperfecciones del oído de las personas para eliminar toda aquella información acústica que no somos capaces de percibir (oír, en este caso).

Esa forma de trabajar que tiene el algoritmo de compresión de JPEG hace que la pérdida de calidad, cuando se realizan sucesivas compresiones, sea acumulativa. Esto es, el simple hecho de abrir un fichero JPG y, sin realizar cambio alguno, guardarlo de nuevo, revierte en una pérdida sustancial de la información del archivo. Cuantas más veces se realice el proceso, más cantidad de información se pierde, llegando a obtenerse, con el paso del tiempo, un archivo objeto totalmente desfigurado y diferente al archivo origen.

La manera de comprobar esto es muy sencilla. Tomemos un archivo JPG cualquiera, lo abrimos con un software de edición de imágenes y lo guardamos, simplemente. Volvemos a guardar, volvemos a guardar y volvemos a guardar. Repetimos este proceso cien veces y, al final, comparamos el último fichero con el primigenio. La diferencia ha de ser notable.

El problema es que la mayoría de los programas profesionales de edición no permiten guardar si no ha habido cambios en el lienzo. Así que el procedimiento se puede convertir en algo eterno, pues habría que cerrar y volver a abrir o, en su caso, hacer algún cambio y deshacerlo (mover la imagen un píxel a la izquierda y otro a la derecha, por poner un ejemplo).

Si queremos ahorrarnos el tiempo de hacer esta prueba, podemos visionar el siguiente vídeo, donde se aprecia la progresión de deterioro ocasionado al abrir y guardar una misma imagen JPG 600 veces seguidas.

Sucesiva pérdida de calidad de un archivo JPG

Como decíamos, pues, la pérdida es acumulativa. Cada vez que guardamos un archivo JPG el algoritmo de compresión actúa eliminando información del archivo previo. Si se comprime una imagen y se descomprime, se perderá calidad de imagen, pero si se vuelve a comprimir una imagen ya comprimida se obtendrá una pérdida todavía mayor. Cada sucesiva compresión causará pérdidas adicionales de calidad. La compresión con pérdida no es conveniente en imágenes o gráficos que tengan textos, líneas o bordes muy definidos, pero sí para archivos que contengan grandes áreas de colores sólidos.

Con pocos guardados de imagen, la diferencia no es perceptible por el ojo humano, sin embargo, se recomienda no trabajar directamente sobre imágenes JPG en el proceso de edición, sino utilizar otro formato (normalmente el nativo de cada software de retoque) para, al final, convertir y comprimir como JPEG. Que lo sepas.

La eterna pugna entre dos tipos duros: Arial y Helvética

Helvética/Arial

Helvética es una familia tipográfica diseñada en 1957 por Max Miedinger, un afamado tipógrafo suizo, para la fundición experta en esta lides conocida como Haas (por supuesto, hablamos de cuando los tipos eran piezas metálicas de imprenta con los caracteres en realce). Su desarrollo se basó en una tipografía anterior denominada Akzidenz Grotesk, datada en 1896.

Más tarde, Haas se unió con Linotype, una empresa norteamericana formada para comercializar la máquina Linotipia y que se convirtió en la mayor compañía de equipamiento para impresión de libros y periódicos del mundo. En esta unión se promovió el uso de la Helvética fuertemente, y durante la segunda parte de siglo XX fue uno de los tipos más populares en el mundo occidental.

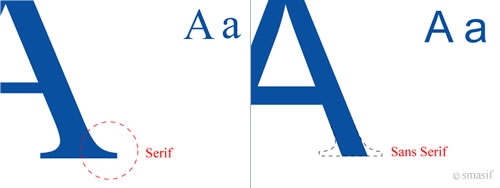

Helvética fue acuñada como un tipo de estilo sencillo y de palo seco, es decir, sin remates, gracias o serifas; lo que los anglosajones (proviniendo del francés) llaman sans serif, esto es, sin serifa. Las serifas (o gracias) son pequeños adornos ubicados generalmente en los extremos de las líneas de los caracteres tipográficos.

Con y sin serifa

Ambas tipografías (Helvética y Akzidenz Grotesk) eran asombrosamente iguales, aunque no al cien por cien. El principal cambio que realizó Max Miedinger en su Helvética fue la conocida como «altura de la x» (el alto que tiene una letra x minúscula y que establece la altura del ojo medio de todas las letras), haciéndola mayor que en la Akzidenz Grotesk, lo cual la hace parecer un poco más oblonga, mientras que la su antecesora mantiene su forma sutilmente aplastada.

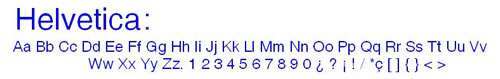

Tipografía Helvética

Por su lado, Arial nace en 1982 de la mano de los diseñadores Robin Nicholas y Patricia Saunders, de la fundición americana Monotype, la competencia directa de Linotype y la única compañía que fue capaz de hacerle sombra a su rival en el mercado de la impresión. En un principio, la idea de Arial surge de la necesidad de responder a la alta popularidad de Helvética, y se desarrolló como fuente principal para las primeras impresoras láser de IBM.

En un principio llamada Sonoran San Serif, Arial tuvo la gracia de caer el manos de Microsoft, ya que la empresa de Redmond no estaba dispuesta a pagar lo que se pedía por Helvética. Cuando el tío Bill hizo de TrueType el formato estándar de fuente para Windows 3.1, se optó, pues, por utilizar Arial en lugar de Helvetica; sabían que la mayoría de la gente no notaría la diferencia ni se preocuparía por ella.

Apple, por otro lado, también hizo estándar el formato TrueType (lo habían desarrollado ellos para competir con el PostScript de Adobe) al mismo tiempo, pero ellos incluyeron Helvetica, y no Arial, como fuente principal, pagando religiosamente los derechos a Linotype.

En aquella época, el dominio de Windows sobre los sistemas de Apple fue aplastante, y ello popularizó de tal forma la fuente Arial que, hoy en día, es la más conocida del mundo. Microsoft siguió apostando fuerte por Arial como tipo base hasta Windows Vista, cuando fue sustituida por la fuente Calibri. Durante todos estos años, Arial ha sido la tipografía más popular sin ningún género de dudas.

Tipografía Arial

Sin embargo, Arial es considerada por los expertos tipógrafos como una copia burda y barata de Helvética, careciendo de las características que distinguieron al diseño original suizo. A pesar de ser casi idéntica a Helvetica en proporciones y peso, el diseño de Arial es una variación de la serie Grotesque de Monotype y fue concebida para ser usada en computadoras, más que para ser leída en papel. Este tipo de letra tiene cambios sutiles en la forma y el espacio entre caracteres con el fin de hacerla más apta para ser leída en una pantalla a distintas resoluciones de imagen.

Lo cierto es que la preeminencia de la Helvética de Linotype en el mercado hizo que Monotype se empeñara en diseñar un tipo de letra prácticamente igual. Sin embargo, y en lugar de fabricar una copia exacta como hicieron otros en la época, se encargó de añadir o quitar pequeños matices que hacían de Arial una fuente muy parecida pero diferente. Aunque, como veremos a continuación, las desemejanzas son tan sutiles, que los profesionales la consideran simplemente un calco de baja calidad gráfica.

Los chicos de ‘I Love Typography’ desarrollaron hace tiempo una simple pero estupenda herramienta a la que llamaron Fontometer (algo así como «fontómetro») y que colgaron en una de las entradas de su blog. Este Fontometer permite comparar los glifos de ambas tipografías haciendo uso de las distintas letras minúsculas del alfabeto inglés. Se encuentra a continuación y su forma de uso es muy sencilla. Únicamente debemos pasar el puntero de nuestro ratón por encima de los caracteres de la línea superior (en letra más grande los que más diferencias tienen a simple vista) para observar la comparación en la zona inferior (a la izquierda, en gris, Arial; a la derecha, en rojo, Helvética).

Una vez seleccionada la letra en cuestión, disponemos de la posibilidad de arrastrar el carácter Arial sobre el carácter Helvética. En este momento, cuando los superpongamos, nos percataremos de las verdaderas diferencias entre ambas fuentes. Nimias pero importantes diferencias (¡en todas las letras!).

La confrontación entre Arial y Helvética viene de viejo. El hecho de que Microsoft se decantara por Arial y Apple por Helvética avivó más las llamas del fuego cruzado. Los diseñadores y maquetadores expertos, muy inclinados hacia Mac OS desde siempre, hacen llagas sobre Arial y la tildan de estafa tipográfica. La verdad es que de Helvética se podría decir lo mismo con respecto a Akzidenz Grotesk. Es la historia de la humanidad y sus derechos de autor: basarse en algo y realizar un duplicado prácticamente exacto, ¿es copia y calco o es homenaje y veneración?

La controversia, por supuesto, ha alcanzado las lindes del friquismo más guasón. Desde ‘Ironic Sans’ nos proponen un divertido juego: han cogido 20 logotipos de famosas empresas diseñados originalmente con Helvética y los han reconstruido en Arial. ¿Sabrías distinguir el original de la imitación? También se puede realizar un test vía ‘I live on your visits’ en el que se propone diferenciar textos escritos en ambas fuentes.

Además, en ‘Mimeartist’ disponen de un juego en Flash en el que has de tomar la identidad de diversos caracteres en Helvética para derrotar y aplastar a letras Arial. Como última curiosidad, comentar que existe una película documental llamada ‘Helvética’ (2007) en la que diferentes diseñadores y tipógrafos hablan sobre este tipo, algunos alabándolo y otros atacándolo.

En fin, una pelea que, como otras tantas, nunca tendrá fin. A mí, personalmente, la verdad es que no me convence ninguna de las dos demasiado. Eso sí, antes que la maldición entre las maldiciones, me quedo con cualquiera de ellas del tirón. Faltaría más.

Cómo se hacían los videojuegos en los años ochenta

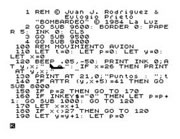

Listado BASIC de un Spectrum

La forma de trabajo de aquellos tiempos era bien distinta a lo que puede ocurrir en la actualidad. En un principio los videojuegos se diseñaban directamente sobre la máquina que los iba a ejecutar. Para ello existía una doble vertiente, en función de la calidad requerida y de los conocimientos del programador: desarrollar en ensamblador o desarrollar en algún lenguaje de alto nivel (comúnmente algún intérprete nativo de BASIC).

La diferencia entre ambas técnicas reside en la potencia del producto final. Evidentemente, programar en ensamblador ayuda a aprovechar al máximo las capacidades del aparato, ya que se hace necesario conocer a la perfección el funcionamiento interno del procesador y del resto del hardware, así como las instrucciones propietarias que presentan y permiten manejar. Hacerlo en un lenguaje de alto nivel acompaña en el proceso, debido a su sencillez de codificación con respecto al ensamblador, pero es muy posible que no exprima al cien por cien el funcionamiento de la máquina.

Para desarrollar un título que fuera compatible con las tres plataformas más conocidas al mismo tiempo, los programadores debían, pues, diseñar el juego para cada una de ellas particularmente, aprovechando muchas veces código en el traspaso debido a que las tres compartían el mismo procesador, un Z80. Sin embargo, el proceso resultaba tedioso y, para las empresas, poco rentable.

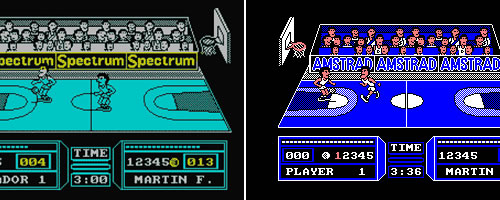

'Fernando Martín Basket Master' para Spectrum

Hacia el año 1987 apareció una herramienta denominada PDS (Programmers Development System), una suerte de sistema que hacía uso de un compilador cruzado y de un equipo de hardware para la época muy avanzado. Este equipo consistía en dos tarjetas, una ISA con dos puertos COM para un ordenador de 16 bit (que hacía las veces de equipo madre de programación) y otra que se insertaba en el equipo de 8 bit y que, en función de este, podía tener forma de cartucho o de periférico adaptado a él.

Desde el ordenador de 16 bit (bien un PC, un Amiga o un Atari) se diseñaba el juego para, después, enviarlo directamente, ya compilado y a través de un cable conectado a las tarjetas mencionadas, a la memoria de la máquina de 8 bit. De esta forma, el desarrollo era mucho más rápido y dinámico a causa de la potencia de los computadores de trabajo y, también, se disponía de la posibilidad de hacer cambios directamente sobre la memoria para comprobar el funcionamiento de los distintos elementos y de depurar errores prácticamente en tiempo de ejecución.

La pega de este sistema PDS es que él solito era capaz de generar las distintas compilaciones para las diferentes máquinas. Esto, que podría parecer una ventaja, sólo así lo era para los empresarios dueños de las producciones, pero no para el público final. El problema reside en que, a pesar de que los tres ordenadores compartan procesador principal, las capacidades gráficas, de audio, de memoria u otras no son las mismas. Por ejemplo, MSX tiene unas aptitudes gráficas bastante mejores que Spectrum, y Amstrad CPC un sistema de sonido también muy superior al de Spectrum.

Ello significaba que la primera versión que se desarrollaba era la de Spectrum para, posteriormente, convertirla, a través de mínimos cambios, para MSX y Amstrad. La inmensa mayoría de los juegos de la época eran conversiones directas de Spectrum, lo que cabreaba bastante a los usuarios de Amstrad o MSX, porque pagaban por juegos para sus plataformas que llevaban gráficos de Spectrum y el sonido chillón de los pitidos del beeper de Spectrum. En fin, no se aprovechaban las capacidades de las distintas máquinas, porque el objetivo era desarrollar rápido y vender mucho. Ojo, no siempre era así, pues algunas compañías como Opera Soft cuidaban muy mucho las versiones.

'Fernando Martín Basket Master' en Spectrum y Amstrad

Ricardo Cancho, a la sazón grafista de Topo Soft, en una entrevista que le hicieron el pasado año 2010 comenta algo que no tiene desperdicio:

Desde el punto de vista técnico, siempre empezábamos por la versión de Spectrum, pero con los cálculos de memoria realizados para el Amstrad. ¿Por qué? Muy sencillo: el Amstrad era el que más consumía en gráficos, literalmente el doble que en las otras máquinas, así que primero había que asegurarse de que el proyecto cupiese entero en esta plataforma. Una vez realizadas las estimaciones, ya podíamos ponernos a hacer gráficos, mapas, etcétera. Así que, paradójicamente, en las versiones de Spectrum siempre quedaba algo de memoria libre de sus 48 KB.

La versión de MSX se dejaba siempre para el final y solía ser un clon de la de Spectrum. El criterio era puramente económico: no se dedicaba ni un minuto de tiempo extra a esta plataforma, para así cumplir los plazos de entrega y de fecha de salida al mercado.

Una auténtica pena que la avaricia de los mercaderes aplastará ríos de imaginación y destreza informática por los siempre putos plazos de entrega. Pero hoy en día no es muy distinto. La única diferencia es que en aquellos tiempos, si realmente se aprovechaban las capacidades de cada equipo, el mismo juego para Sprectrum y MSX eran completamente polos opuestos. Hoy, si dejamos aparte la Wii de Nintendo por su clara inferioridad técnica, es lo mismo ser un poseedor de una PlayStation 3 o de un Xbox 360, porque los juegos se ven y se perciben de una forma exactamente igual en ambas plataformas. Y esto es algo que no tiene mucho sentido.

Ambas consolas actuales tienen unas capacidades similares, pero no iguales. Cabría pensar, además, que el hecho de que el soporte nativo de PlayStation 3 sea el Blu-ray Disc y el de Xbox 360 sea el DVD podría llevar aparejada una mayor cantidad de contenidos en los juegos de la consola de Sony (más niveles, más cortes de vídeo…), pero no es así. Los títulos para ambas consolas son prácticamente iguales, y las diferencias que se pueden encontrar son tan nimias que no merece la pena siquiera tenerlas en cuenta. Lo único que hoy día debería considerar un comprador a la hora de decidirse por una u otra, es el precio y, sobre todo, el catálogo de juegos.

'Dead Rising 2' en Xbox 360 y PS3

¿Qué es lo que impulsa esta tendencia? ¿Por qué se hacen juegos idénticos? ¿A qué oscuro acuerdo se ha llegado? Porque todo el mundo está de acuerdo en que, si se deseara realmente y se aprovecharan al máximo las capacidades de cada máquina, la guerra entre Sony y Microsoft podría ser brutal. Pero eso no ocurre, ni ocurrirá. La historia se repite, no sabemos si por motivos económicos, de mercado o de lo que fuere.

Para el que quiera profundizar más en este tema, desee disfrutar de un buen rato y tenga hora y cuarto que perder (o que ganar), os dejo con un podcast de RetroActivo, uno de los blog más interesantes, maduros, completos y profesionales del mundo retro de la informática y los videojuegos. En este vídeo ha tenido esta entrada su inspiración, pero os recomiendo el resto también sin ningún género de dudas.

Podcast #3 de RetroActivo