Los salvapantallas de los noventa que consumían más recursos que un videojuego

Hubo una época —y no hace tanto, aunque parezca prehistoria informática— en la que el PC no estaba precisamente para florituras. Vivíamos felices con nuestros 166 MHz, con 32 MB de RAM que eran oro puro, y con sistemas operativos que tenían la misma estabilidad que una torre de Jenga montada encima de un ventilador. En ese mundo hostil nació una de las criaturas más entrañables y, al mismo tiempo, más peligrosas que han habitado en un escritorio: el salvapantallas. Aquellas pequeñas piezas de software se suponía que estaban ahí para evitar que se quemara la pantalla de los monitores CRT, pero todos sabemos que, en la práctica, muchas veces sólo conseguían quemar la paciencia del usuario o la dignidad del procesador.

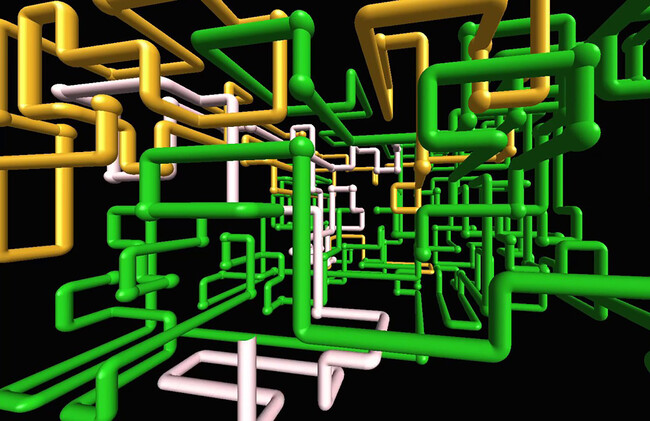

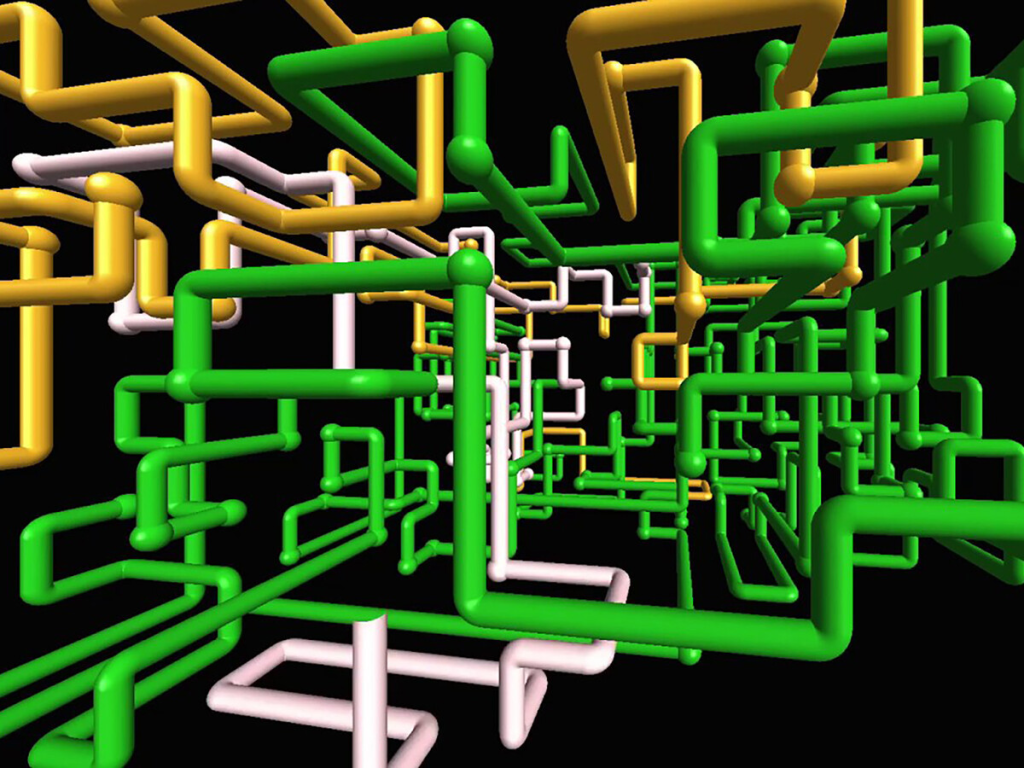

Entre todos ellos brillan —o chisporrotean— dos leyendas que marcaron a fuego la historia de cualquier PC noventero: el mítico Starfield (Campo de estrellas, en castellano) y las no menos famosas e hipnóticas 3D tubes (que se tradujo como Tuberías 3D) renderizadas en OpenGL. El primero te hacía sentir como si tu equipo fuese la USS Enterprise acelerando hacia un espacio de salto; el segundo convertía tu humilde Pentium en un alto horno siderúrgico a base de tubos que se generaban, crecían y se iluminaban sin piedad. Eran fascinantes, sí, pero también eran benchmarks encubiertos y trampas de rendimiento para máquinas que ya bastante tenían con mover el puntero del ratón sin atragantarse.

Campo de estrellas, por ejemplo, era poco más que un montón de puntos blancos viniendo hacia ti. Simulaba un salto al hiperespacio, lo cual, en los noventa, era lo más parecido que tendríamos a una experiencia espacial real sin ser millonarios. Lo gracioso es que la velocidad de esos puntos era una especie de prueba del algodón sobre la salud de tu PC: si iban a tirones, tu tarjeta gráfica estaba al borde del colapso; si se movían fluidos, eras el rey del barrio; y si se desplazaban en direcciones raras, probablemente tu driver VGA había decidido improvisar. Que este protector de pantalla naciera para evitar quemados en el monitor era casi anecdótico. La verdadera razón de activarlo era quedarse mirando embobado pensando «algún día viviremos así», mientras el PC sudaba para mantener los FPS.

Tuberías 3D era otra cosa. Aquello era pornografía del OpenGL. Un entramado infinito de caños que se generaban en tiempo real, giraban, se cruzaban, se iluminaban…; un delirio gráfico que hoy podría mover cualquier reloj digital barato, pero que, a la sazón, dejaba al procesador como si viniera de correr una maratón cuesta arriba. Los primeros segundos eran hipnóticos, casi elegantes, pero al poco rato el ventilador del microprocesador empezaba a sonar como si intentara despegar. El puntero del ratón se movía con la dignidad de una gelatina temblorosa y, en el mejor de los casos, la animación terminaba con un cuelgue. En el peor, con un pantallazo azul que parecía más arte conceptual que mensaje de error.

La pregunta lógica es por qué demonios estos salvapantallas consumían tantos recursos. La respuesta es maravillosa por su simplicidad: porque podían. En una época en la que el PC estaba la mayor parte del tiempo «descansando», los desarrolladores vieron en los salvapantallas un territorio sin reglas, un paisaje libre donde se podían permitir el lujo de experimentar sin pensar demasiado en el rendimiento. Algunos simulaban modelos 3D sin optimizar, otros no limitaban los FPS, otros se anclaban a bucles infinitos que ignoraban cualquier tipo de carga del sistema. Con frecuencia, parecían más demostraciones técnicas camufladas que utilidades pensadas para proteger nada. Y el usuario, mientras tanto, feliz de ver el espectáculo. Hasta que tocaba mover el ratón y descubrir que todo el sistema había envejecido diez años durante la última hora.

Pero si los salvapantallas oficiales ya eran curiosos, los de terceros eran directamente una jungla posapocalíptica del software. Había peces tridimensionales que parecían haber escapado de una rave, acuarios falsos que repetían la misma textura cutre en mosaico hasta marearte, simulaciones de fuego que consumían tanta CPU que daban ganas de apagar el monitor para no tentar al destino e incluso salvapantallas interactivos que respondían al sonido del micrófono (cuando no se colgaban sencillamente porque habías estornudado). Y luego estaban joyas como After Dark, con sus ovejas saltarinas, sus tostadoras voladoras y sus pingüinos suicidas. Todos ellos eran experimentos, bromas internas hechas software y ocurrencias llevadas al extremo sin supervisión adulta.

Con el tiempo, los monitores dejaron de necesitar protección, la tecnología LCD mandó a la hoguera los quemados de fósforo, y los salvapantallas fueron quedando como un vestigio de otra época. Pasaron de ser una necesidad técnica a un lujo inútil y, de allí, a convertirse en una reliquia. De hecho, en los sistemas modernos siguen estando ahí, escondidos, como dinosaurios amables esperando a que alguien los invoque por nostalgia. Ya nadie instala tuberías, ni estrellas, ni peces rave; la pantalla simplemente se apaga, como un adulto aburrido que ya no tiene energía para videojuegos.

Y aún así, algo de magia queda. Porque aquellos salvapantallas eran un símbolo, una muestra de que en el software también había espacio para lo innecesario, para lo bello, para lo absurdo y para lo experimental. Fueron un recordatorio de que la informática del siglo pasado no siempre era práctica, pero sí era creativa. Nos enseñaron que un PC podía comportarse como un horno, que el OpenGL podía convertirse en enemigo íntimo del rendimiento, que no todas las animaciones necesitaban de un propósito y que, de vez en cuando, una idea inútil podía convertirse en un icono.

Hoy, cuando recordamos el viaje estelar o las tuberías asesinas que parecían empeñadas en derretir tu Pentium, no pensamos en los cuelgues ni en el ruido del ventilador. Pensamos en las noches frente al monitor, en la sensación de asombro, en ese momento en el que la animación se convertía en una especie de teatro doméstico. Pensamos, en definitiva, en un pedazo de historia digital que, aunque ya no cumpla ninguna función, sigue ocupando un lugar cariñoso en la memoria de quienes lo vivieron.

El bus VLB: cuando decidieron ponerle un cohete a la placa base y salió regular

El VESA Local Bus, más conocido como VLB, fue uno de esos inventos que solo pudieron nacer en los turbulentos años noventa, cuando la industria del PC estaba creciendo a un ritmo demasiado rápido como para esperar a que Intel lo resolviera todo con elegancia.

A principios de aquella década, la transición del 386 al 486 había disparado la capacidad de cálculo del procesador, pero el resto del sistema, especialmente el venerable bus ISA, seguía arrastrándose con sus 16 bits a 8 MHz y un ancho de banda que hoy haría sonrojar a un reloj digital de los chinos. El resultado era un cuello de botella monumental, sobre todo en un área que empezaba a adquirir importancia crítica: el vídeo. Los modos SVGA, las resoluciones superiores a 640×480 y el incremento del consumo gráfico exigían un canal más rápido entre el procesador y las tarjetas de expansión. El ISA no daba más de sí, y el EISA, aunque mejorado, era caro y orientado a servidores. La industria doméstica necesitaba una solución inmediata, barata y lo suficientemente potente para aguantar hasta que apareciera un estándar más serio.

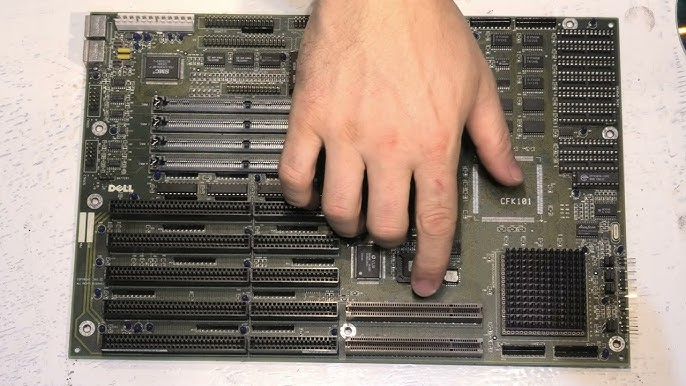

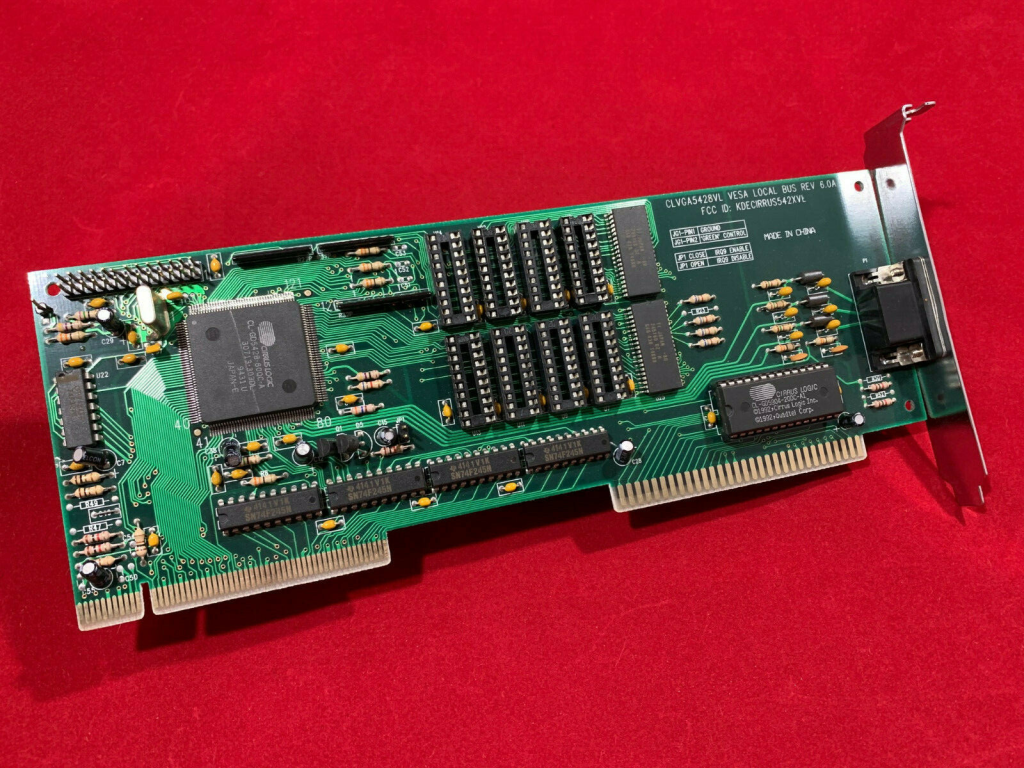

Ahí entró en juego la Video Electronics Standards Association (VESA), una agrupación de fabricantes preocupados por la interoperabilidad de los estándares gráficos. En 1992 propusieron una solución atrevida y claramente transitoria: un bus que literalmente colgase del bus local del procesador 486, aprovechando sus líneas de datos de 32 bits y su frecuencia de reloj, normalmente entre 25 y 50 MHz. El resultado fue el VLB, un bus con un rendimiento teórico de más de 100 MB/s, lo cual rondaba entre diez y quince veces la capacidad del humilde ISA. La idea era tan simple como peligrosa, pues si el problema se concentraba en que el bus ISA era lento, ¿por qué no permitíamos a la tarjeta gráfica acceder directamente al bus del procesador? Era como dejar a un mecánico enchufar un turbo al motor sin avisar al fabricante del coche. Pero la necesidad era urgente, y el truco funcionó.

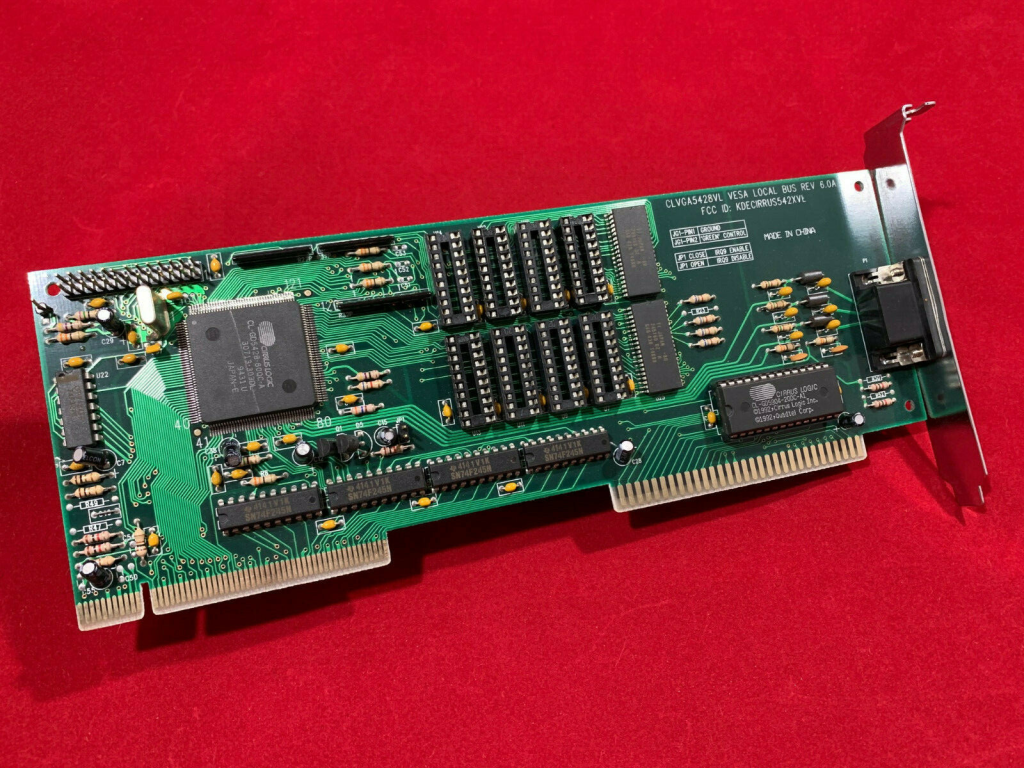

Físicamente, el VLB consistía en un conector adicional situado a continuación de la ranura ISA estándar. Por eso las tarjetas VLB eran tan largas, porque una parte ocupaba la ranura ISA tradicional y otra encajaba en la extensión VLB, como si hubieran injertado dos tarjetas en una. Esa longitud extrema no era un capricho, sino consecuencia del número de señales adicionales que el bus necesitaba para sincronizarse con el microprocesador. Y aquí empezaban los problemas, pues al depender directamente del reloj del CPU, cualquier variación en la placa base, cualquier imprecisión en las pistas o cualquier exceso de longitud podía provocar inestabilidad.

Las placas base tenían que diseñarse como si fueran instrumentos de precisión, porque las señales de VLB no toleraban retardos significativos. Los fabricantes solían anunciar compatibilidad con 40 MHz, pero muchos equipos se desplomaban al intentar usar el bus por encima de 33 MHz. Además, aunque el estándar permitía hasta tres ranuras VLB por placa madre, pocas se atrevían a implementar más de una y, cuando incluían dos, hacerlo funcionar todo a la vez y sin errores era casi un acto de magia.

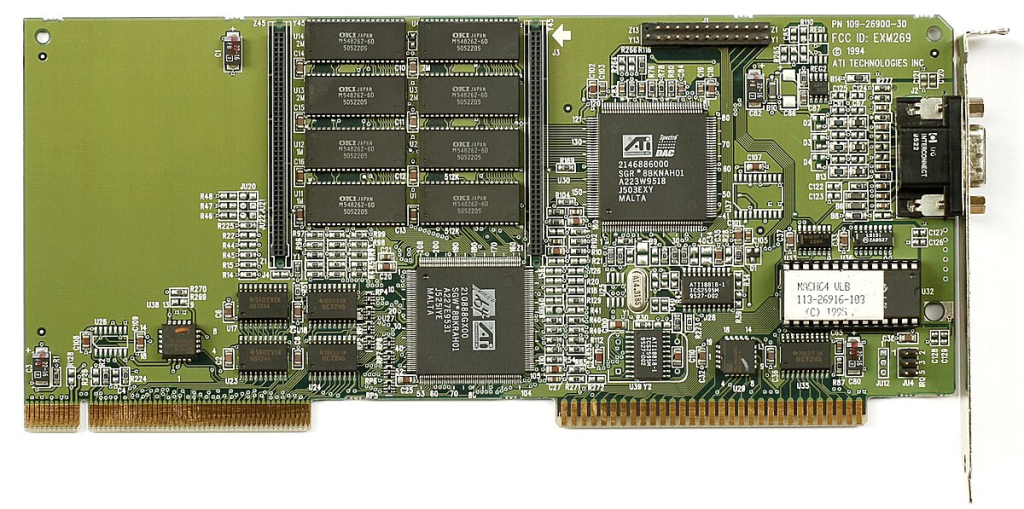

El propósito principal del VLB fue acelerar las tarjetas gráficas. En 1992 y 1993, cuando los chips de Cirrus Logic, S3, Tseng Labs o Trident dominaban el mercado SVGA, disponer de un bus rápido podía marcar una diferencia sustancial en operaciones de transferencia de vídeo, escritura en framebuffer y uso de aceleración 2D primitiva.

Pero las gráficas no fueron las únicas beneficiadas. Muy pronto comenzaron a aparecer controladoras IDE y SCSI con interfaz VLB, aprovechando el mayor ancho de banda para transferencias de disco. También surgieron tarjetas de red y adaptadores multi-I/O que, sobre el papel, prometían un rendimiento superior al de sus equivalentes ISA. La realidad era más ambivalente, ya que no todas estas tarjetas lograban beneficios tangibles, pero cuando lo hacían, el salto era apreciable. Para un PC doméstico de mediados de los noventa que dependía del 486, el VLB era, sin exagerar, la única vía práctica para obtener un rendimiento gráfico competitivo.

El motivo de su caída fue, precisamente, su propia naturaleza improvisada. El VLB estaba diseñado alrededor del 486 y no tenía futuro más allá de él. Pentium introdujo cambios sustanciales en el bus del procesador y exigía una arquitectura completamente distinta para la comunicación con dispositivos de expansión. Intel llevaba años desarrollando un estándar más sofisticado, independiente del reloj del procesador, más estable, más escalable y más apto para un ecosistema en expansión: el bus PCI, que comenzó a imponerse hacia 1994 y se convirtió en el estándar dominante apenas un año después. Frente al PCI, el VLB parecía lo que realmente era: un puente improvisado. No soportaba bien mayores frecuencias, no era compatible con arquitecturas posteriores, carecía de mecanismos avanzados de arbitraje y su dependencia directa del procesador imponía restricciones insostenibles. Cuando las placas base para Pentium empezaron a llegar en masa, prácticamente todas eliminaron el VLB y adoptaron PCI de forma contundente.

Podría parecer que el VLB fue un fracaso, pero sería injusto. Cumplió exactamente la función para la que fue creado: ofrecer una interfaz de alta velocidad en los meses en los que no existía otra alternativa viable. Permitió que los 486 exprimieran todo su rendimiento gráfico justo cuando más se necesitaba, mantuvo viva la competitividad de los PC compatibles frente a estaciones propietarias y, de paso, evitó que el ISA siguiera lastrando al mercado un par de años más. Fue un invento efímero pero crucial, una pieza de ingeniería pragmática que resolvió un problema urgente a pesar de ser frágil, caprichosa y tremendamente sensible a las particularidades del hardware.

Hoy, ver una tarjeta VLB es casi un ritual arqueológico: largas, pesadas, con el conector doble característico; recuerdan una época en la que la informática de consumo avanzaba tan deprisa que los estándares nacían con fecha de caducidad incorporada. El VLB no sobrevivió a su tiempo, pero dejó una huella decisiva en la transición tecnológica de los primeros noventa. Fue un puente, sí, pero un puente que sostuvo todo el peso del mercado mientras la industria corría a construir algo mejor.

El fenómeno viral antes de que existiera el fenómeno viral

Hubo un tiempo en el que no existía la «viralidad» como concepto. No había algoritmos empujando contenido, no existía el hecho de compartir con un clic, ni los hashtags, ni la obsesión colectiva por medir métricas. Y aun así, de alguna manera, Internet ya bullía con pequeños fenómenos que hoy, vistos con perspectiva, eran los auténticos precursores de lo viral. Eran torpes, primitivos, caóticos…, pero tenían un encanto que hoy es imposible replicar.

Los primeros contenidos virales vivían en Geocities, en Tripod, en Lycos y en páginas hechas con FrontPage o con el Bloc de notas, todas llenas de GIF chillones y banners parpadeantes con textos en <marquee>. La viralidad no se medía en millones de visualizaciones, sino en cuántos amigos conseguías convencer para visitar tu página. Era una especie de colegueo digital: tú veías la web cutre de un amigo, él veía la tuya, y ambos presumíais de tener contadores de visitas trucados que siempre marcaban 1035 sin que hubiese pasado nadie por allí.

Los banners fueron, quizá, el primer intento serio de algo parecido a la difusión masiva. Banners de intercambio, banners de afiliación, banners que te obligaban a poner en tu web a cambio de aparecer en la suya. El objetivo era simple: salir en cuantas más páginas mejor, aunque fueran botoncitos de 88×31 píxeles. Esa era la unidad mínima de notoriedad en la prehistoria de la web. Con suerte, alguien hacía clic, acababa en tu web y se quedaba lo suficiente como para dejar un mensaje en tu libro de visitas. Si eso ocurría, podías darte por satisfecho, porque habías logrado un algo viral a escala doméstica.

Los GIF animados fueron la otra fiebre. No tanto por su utilidad, sino porque destacaban en un océano de HTML estático. Si tu web tenía un gatito bailando, un fuego ardiendo por detrás del texto o un buzón que se abría y se cerraba cuando pasabas el ratón, automáticamente se hacía memorable. Cuanto más hortera, mejor. Había colecciones enteras de GIF repartidas por servidores gratuitos. Aquello era una carrera por ver quién lograba la combinación más llamativa. Si la gente compartía tu GIF en sus páginas, habías ganado. Ése era el «retuit» primigenio.

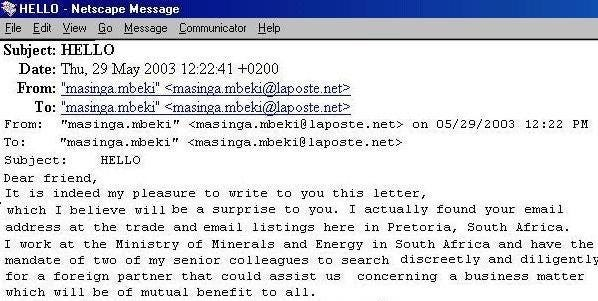

Pero, quizá, los verdaderos contenidos virales de aquella época llegaban por donde nadie supondría hoy: el correo electrónico. Las cadenas de email fueron, sin saberlo, las embrionarias redes sociales. Llegaban mensajes del tipo «si no reenvías esto a 10 personas, te ocurrirá algo terrible mañana», «esta niña necesita tu ayuda, reenvía este correo para que reúna dinero», o «lee este chiste y pásalo». Eran tóxicos, falsos, redundantes, pero se propagaban como auténticos incendios. Y lo fascinante es que funcionaban: las personas reenviaban esos correos por miedo, por humor o simplemente por aburrimiento. Aquello era viralidad pura, pero sin nombre ni teoría detrás.

Incluso había fenómenos más oscuros, como los archivos .EXE que prometían animaciones mágicas: pequeñas aplicaciones hechas con Visual Basic o Flash que mostraban dibujos, mensajes motivadores o tonterías varias. Normalmente pesaban menos de 200 KB y venían por correo electrónico con un asunto del tipo «Mira esto antes de borrarlo». Eran inocentes, casi siempre. Los virus reales llegarían después, cuando Internet empezara a masificarse y la ingenuidad colectiva dejara de ser una armadura suficiente.

Había una inocencia tecnológica hermosa en todo eso. El éxito no estaba cuantificado; no había estadísticas globales, ni dashboards, ni curvas de crecimiento exponencial. Sólo sabías que algo se había propagado cuando te llegaba por duplicado a la misma bandeja, reenviado por dos amigos distintos que no se conocían entre sí. Ese momento era revelador: habías presenciado un fenómeno viral analógico en un medio digital.

Hoy la viralidad es un negocio industrial, estudiado, explotado y (a menudo) manipulado. Entonces, era artesanal. Tenía textura. Olía a páginas hechas a mano, a HTML mal cerrado, a contadores de visitas incrustados, a archivos GIF recortados con Paint Shop Pro y a correos enviados desde Outlook Express. Y aunque hemos ganado eficiencia y escala, hemos perdido ese caos genuino.

Aquellos primeros virales no buscaban convertirte en influencer, sólo querían llamar la atención durante un segundo, sorprenderte, hacerte sonreír o molestarte lo suficiente como para que tú también los compartieras. Eran, quizá, la versión más pura de lo que hoy llamamos «viralidad»: elementos que se propagaban porque las personas querían propagarlas, no porque un algoritmo las aupara.

Era un Internet más pequeño, más sencillo y más humano. Y por eso, precisamente, sus contenidos virales se recuerdan con tanta claridad.

Cuando «Loquendo» hablaba por los codos

Hubo un tiempo, allá por los dosmiles, en el que Internet comenzó a hablar, pero no con voz humana. Hablaba con una voz robótica, metálica y, a ratos, inintencionadamente cómica. Hablaba con Loquendo (pronunciado /lo.cuén.do/). Pero todo aquello venía de mucho tiempo atrás.

Loquendo TTS (Text To Speech) fue uno de los sistemas de conversión de texto a voz más reconocibles de aquella década. Detrás estaba la empresa italiana Loquendo S.p.A., una derivación tecnológica de Telecom Italia que desarrolló motores de síntesis de voz en múltiples idiomas. Sin embargo, fue su versión en español la que se convirtió en estrella inesperada del circo digital. En particular, la voz masculina conocida como «Jorge» se ganó un lugar especial en la cultura digital en línea por su tono monocorde, su acento indefinible y una cadencia que, sin quererlo, aportaba más dramatismo que muchos actores profesionales.

Loquendo era, originalmente, una comunidad de investigación creada a mediados de los años setenta del siglo pasado por los administradores del IRI-STET (predecesora de Telecom Italia) en los laboratorios de CSELT (Centro se Estudio y Telecomunicaciones, en Turín) antes de convertirse en una compañía, en 2001. Aplicando la técnica de los llamados difonos (la unión de una consonante y una vocal, 150 en total en el idioma italiano), el grupo creó el primer sintetizador de voz alta gran inteligibilidad en 1975, al que llamaron MUSA (por sus siglas en inglés de Multichannel Speaking Automaton), y que demostró que aquello era más que posible con la tecnología de la época.

Posteriormente, en los años noventa, nació Eloquens, un sintetizador de voz multiplataforma para varios sistemas operativos —incluyendo DOS, Windows, System 7 y Unix— y también para tarjetas telefónicas con varios canales, como las usadas por las operadoras de telefonía italianas para obtener la dirección y la identidad del suscripto a la red.

Loquendo se hizo viral antes de que el concepto de «viral» existiera como tal. Su popularidad explotó gracias a la escena emergente de creadores en YouTube, cuando la plataforma aún era joven, tosca y libre. Para muchos adolescentes sin micrófono o sin ganas de exponer su voz, Loquendo era la solución perfecta: escribías el guion, lo pegabas en el programa, le dabas al botón de reproducir y ya tenías a Jorge leyendo tus pensamientos con la misma emoción que un cajero automático. Sin embargo, funcionaba. Funcionaba porque esa neutralidad robótica tenía una magia extraña, un carisma que se colaba en vídeos de terror, en tutoriales para hackear el Messenger, en historias inventadas de encuentros con lo paranormal o en los ranking de los 10 juegos más malditos de la historia.

Internet se llenó de narraciones leídas por Loquendo. Era omnipresente. En algunos rincones de YouTube, incluso parecía que no había otro modo de contar una historia. La estética era reconocible: fondo negro, letras rojas en fuente Comic Sans o Impact, música ambiental de Silent Hill y aquella voz artificial diciendo cosas como: «Hola, amigos de YouTube. Hoy les traigo una historia real que me pasó cuando tenía seis años».

El software no solo hablaba, también obedecía. Algunos usuarios descubrieron que podían manipular su entonación, insertar pausas o trucos tipográficos para simular emociones. Había cierta artesanía en usar Loquendo bien, como un doblaje artesanal de ciencia ficción de serie B. Incluso llegó a existir una especie de competencia por ver quién podía hacer decir a Jorge las frases más surrealistas y provocadoras sin que sonara ridículo…, o precisamente buscando que sonara lo más ridículo posible.

Con el tiempo, las voces sintéticas evolucionaron. Se volvieron más realistas, más cálidas, más humanas. Y con ello, paradójicamente, perdieron parte del encanto. Loquendo fue comprado por Nuance Communications en 2011 y, poco después, su motor de voz dejó de estar disponible para el público general. Los asistentes de voz como Siri, Alexa o Google Assistant tomaron el relevo, con sus dicciones limpias y calculadas. Pero ninguno de ellos hizo reír, asustó o narró absurdeces como Jorge. Ninguno pasó a formar parte de la mitología de Internet como lo hizo esa voz sin alma pero con tanto carácter.

A día de hoy, aún sobreviven cientos —sino miles— de vídeos con Loquendo repartidos por la Red como cápsulas de una época. Son vestigios de una Internet distinta, menos profesional, más caótica e infinitamente más libre. Escuchar a Jorge hoy es un viaje en el tiempo, una mezcla de nostalgia y risa, como leer tus propios mensajes de Tuenti o revisar una carpeta de GIF animados en un pendrive perdido.

Quizá nunca debimos dejar que Jorge se callara. O quizá su voz era sólo para aquel Internet que ya no existe. Pero, si prestas atención, si rebuscas entre los rincones de YouTube, es posible que todavía lo escuches decir aquello de «hola, amigos de YouTube…”.

Sound Blaster: la tarjeta de sonido que puso música a nuestra infancia digital

Hubo un tiempo en que los ordenadores eran mudos, silenciosos, como si estuvieran enfadados con el mundo o no tuvieran nada interesante que decir. A lo sumo, un triste bip monofónico salía del altavoz interno al encenderlos, como un bostezo electrónico. Y gracias, porque para muchos juegos de la época ese altavoz de la placa era el único intérprete disponible: chasquidos metálicos, pitidos que simulaban disparos y melodías reducidas al rango más pobre.

En aquella era prehistórica del audio digital, algunos pioneros se atrevieron a meter tarjetas de sonido en los PC. Una de las primeras fue la AdLib, canadiense ella, que usaba un chip Yamaha OPL2 para ofrecer síntesis FM. Sintetizar música, sí, pero con matices. Aquella tarjeta fue como pasar del ruido de una impresora matricial a una cinta de casete de los 40 Principales. Pero la AdLib, por rompedora que fuera, tenía una limitación importante: sólo podía generar sonidos, no reproducir muestras digitales. No podías escuchar una voz grabada, ni un disparo realista, ni el grito de un personaje pixelado, por ejemplo. Y entonces llegó Creative Labs, desde Singapur, y lo cambió todo.

La primera Sound Blaster apareció en 1989 y era, literalmente, una AdLib vitaminada. Compatible 100 % con los estándares de moda, pero además con capacidad para reproducir audio digitalizado, algo que en aquel momento sonaba (nunca mejor dicho) a ciencia ficción. Y como guinda, incluía un puerto de joystick integrado, lo que hacía que los adolescentes ya no tuvieran excusa para no jugar a Wing Commander como se debía.

Aquel movimiento fue brillante: Creative no sólo sacó una tarjeta mejor, sino que la hizo compatible con lo que ya existía, facilitando su adopción por desarrolladores y usuarios. En muy poco tiempo, Sound Blaster se convirtió en el estándar de facto del sonido para PC. Si un juego era serio, tenía que soportarla. Y si no la tenías, te sentías medio cojo.

Los años noventa fueron el reinado absoluto de la familia Sound Blaster. La Pro, la 16, la AWE32, la AWE64…, cada una mejoraba a la anterior con más canales, más calidad, más memoria para soundfonts, en general, más cacharrería para que los juegos sonaran a gloria. Aquellos que recuerden el salto de un Commander Keen en speaker a un Doom con música MIDI y efectos PCM sabrán de lo que hablamos. Era como pasar de una maqueta a una película de verdad.

Eso sí, instalar una de estas tarjetas no era tarea para cobardes. Había que lidiar con puertos I/O, canales DMA, las IRQ que se peleaban con la controladora IDE o con el módem de 14,4 kbps. Te pasabas más tiempo configurando el autoexec.bat y el config.sys que jugando. Pero cuando lo conseguías… Escuchar la voz digitalizada de Guybrush Threepwood en Monkey Island o el rugido de una ametralladora en Duke Nukem 3D valía cada minuto perdido.

El impacto fue tal que, hasta en la demoscene, la Sound Blaster se convirtió en pieza clave. Los ficheros MOD, la música tracker, las demos de 64K que metían tecno ochentero con sincronización visual…, todo se apoyaba en esa tarjeta, en esa capacidad de reproducir samples a distintos tonos, en ese chip que parecía sacado de una radio pirata del futuro.

Pero todo reinado llega a su fin. Con la llegada de Windows 95 y DirectSound, muchas cosas cambiaron. El sistema operativo empezó a abstraer el hardware, los fabricantes de placas base comenzaron a integrar audio suficientemente bueno y la necesidad de comprarse una tarjeta dedicada fue desvaneciéndose. Creative resistió durante años con las gamas Audigy y X-Fi, incluso flirteando con los jugadores hardcore con latencias bajas y efectos envolventes, pero el mercado ya no era el mismo.

Hoy en día, las Sound Blaster viven en el recuerdo, en los foros de retrohardware, en los emuladores como DOSBox y en los corazoncitos de quienes alguna vez escuchamos por primera vez una voz digitalizada en un PC y dijimos «¡esto habla!». Algunos entusiastas aún las usan para revivir máquinas antiguas y jugar como en los viejos tiempos, con drivers que hay que buscar en disquetes, en páginas abandonware, o en archivos ZIP con nombres como sb16drv.zip.

La Sound Blaster no fue sólo una tarjeta de sonido, fue la primera vez que un PC tuvo alma, que dejó de ser un robot mudo y se convirtió en una máquina capaz de emocionar. Nos enseñó que los bits también pueden cantar. Y eso, para quienes lo vivimos, es un algo que ya no se olvida.