Entradas de la categoría ‘Informática en general’

Cómo funciona una tarjeta de red

NIC

La tarjeta de red produce el voltaje necesario para enviar la señal a través de la red. Un puerto en el origen establece una conexión eléctrica con un conector RJ-45 sobre el cable de red que envía el mensaje, codificado en señales eléctricas, además de otras características como la dirección MAC (Media Access Control) de la tarjeta almacenada en un chip ROM de la misma. La MAC es un identificador único para cada tarjeta de red utilizada en cualquier envío de datos a través de una red informática.

¿Y a la hora de recibir? Pues tres cuartos de lo mismo: la tarjeta recibe los impulsos eléctricos que, automáticamente, convierte en un lenguaje comprensible a la máquina, esto es, en ceros y unos.

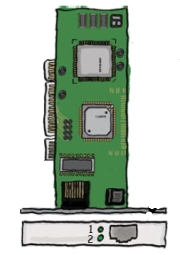

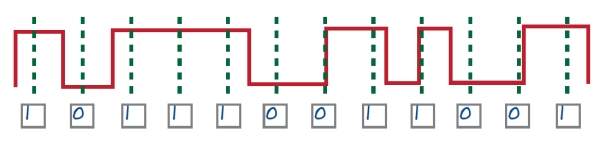

Existen tres métodos diferentes para que una misma señal sea transformada a sistema binario, a saber: Non-Return-to-Zero (NRZ), Non-Return-to-Zero Inverted (NRZ-I) y la conocida como codificación Manchester. En todos ellos, la señal eléctrica es recibida por la NIC como series de cambios de voltajes que han sido transmitidos a lo largo del cable (imagen siguiente). Cada método tiene sus ventajas y sus inconvenientes.

Cambios de voltaje

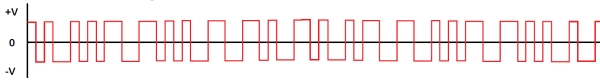

La señal es dividida en porciones iguales haciendo uso de un mecanismo de reloj, es decir, un dispositivo que emite pulsos regularmente, proveyendo así de un «latido» uniforme que trocea la señal en partes idénticas (líneas de trazos verdes de la figura siguiente).

Pulsos de reloj

La señal, pues, es convertida a ceros y unos en función del nivel de voltaje en el que el pulso del reloj se corta con la señal eléctrica, determinando así cuándo es un 0 y cuándo un 1. Para decidir esto entran en juego los tres métodos antes mencionados. En el primero de aquellos, el NRZ, cuando una línea horizontal alta de señal cruza a una línea vertical de reloj, tenemos un 1. Cuando una línea horizontal baja encuentra a una línea vertical, entonces tenemos un 0. La siguiente imagen muestra esto gráficamente.

Método NRZ

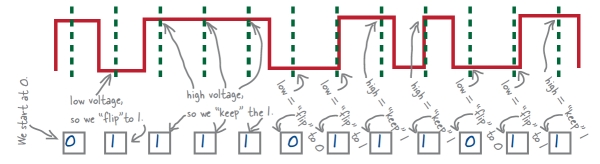

El segundo de los métodos (NRZ-I) empieza siempre con un 0. Cuando una línea horizontal alta de señal encuentra a una línea vertical de reloj, se repite el número (0 ó 1) anterior. Por su lado, cuando una línea horizonal baja se cruza con una línea vertical, se cambia al número opuesto. Veamos un ejemplo en el siguiente gráfico.

Método NRZ-I

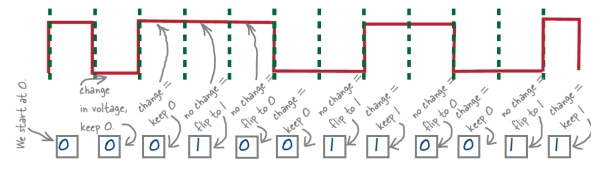

En el método Manchester, siempre que la señal cambia de alto a bajo voltaje, tenemos un 0. Así pues, siempre que la señal cambia de baja a alta, se codifica un 1. El siguiente ejemplo esclarece este sistema.

Método Manchester

El estándar 10BASE-T, utilizado preferentemente en las redes Ethernet, usa por convenio el método Manchester de codificación, mientras que las tarjetas de red suelen servirse del NRZ como procedimiento interno de funcionamiento. Es por ello que se debe producir una conversión implícita para el correcto funcionamiento. Cuando un equipo informático envía información por la red, dicha información (binaria) llega a la NIC. Dentro de la tarjeta, los datos NRZ codificados se combinan con los pulsos de reloj para crear la señal Manchester. En ese momento, la información ya se puede remitir por el cable. A la hora de recibir, el proceso es el inverso: la tarjeta captura la señal Manchester codificada, la transforma en NRZ y la envía a la CPU en formato binario.

Diferentes métodos de codificación tienen diferentes ventajas; unos son más eficientes, otros tienen mejores funciones de corrección de errores, etcétera. Pero son necesarios, porque sin ellos no podríamos convertir la señal eléctrica que viene por la red al código binario que nuestra computadora entiende. ¿Y qué es lo que hace nuestra máquina para convertir ese código binario a algo comprensible por nosotros, humanos torpes y cuadriculados? Muy fácil.

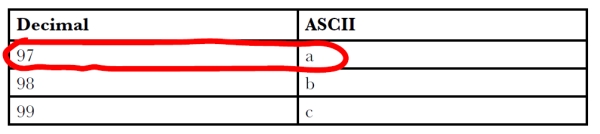

Los ordenadores pueden manejar números en binario que, a su vez, pueden ser convertidos en sus correspondientes decimales (o hexadecimales, octales…). Para transformar estos números en letras, utilizamos una tabla de equivalencias conocida como ASCII (American Standard Code for Information Interchange). Un único byte (8 bits) es suficiente para representar un carácter. Para saber el carácter ASCII que se corresponde con un número o código, el ordenador utiliza una lista de correspondencia simple como la de la siguiente imagen.

Tabla ASCII

Y así es cómo funciona esto; sin más. Algo sencillo de entender y que se realiza en menos de lo que dura un parpadeo. Las conexiones de red nos acercan a Internet a golpe de voltajes y pulsos de reloj. Que lo sepas.

FUENTE DE LAS IMÁGENES: Libro ‘Head First Networking’, de la editorial O’Reilly.

Por qué no debemos girar las fotos

Rotando ando

Un alto porcentaje de las cámaras fotográficas que se venden hoy día para el público no profesional almacenan los archivos de imagen en formato JPEG. Como sabemos, porque ya hablamos de ello por aquí, el algoritmo JPEG es un método de compresión con pérdida de calidad acumulativa, es decir, que sucesivas compresiones provocan subsecuentes pérdidas sustanciales de información. La forma que tiene de trabajar este algoritmo, pues, hace que el simple hecho de abrir una imagen JPG y, sin hacer ningún cambio, guardarla de nuevo, provoque una merma en la calidad de la misma. Progresivos guardados terminan malogrando sin remedio la calidad inicial de la foto.

Por lo tanto, el hecho de girar una fotografía con cualquier software redunda en tener que guardarla de nuevo, con lo que estaremos disminuyendo su nitidez. Y no nos llevemos a engaño, los giros automáticos que realizan las herramientas integradas en los sistemas operativos del tipo ‘Visor de imágenes y fax de Windows’, implican un guardado de imagen después del giro. De hecho, este tipo de programas suelen avisar muchas veces de lo que puede suceder si rotamos la fotografía.

Original (49 KB) y girada (47 KB)

Pero no sólo eso. Hasta ahora hablamos únicamente de girar imágenes un ángulo que sea múltiplo de 90º, en las que la pérdida de calidad es poco apreciable por el ojo humano. ¿Pero qué ocurre si rotamos una foto un ángulo distinto a 90º, 180º ó 270º? El estropicio es descomunal.

Supongamos una imagen como la siguiente (la de la izquierda). Es un JPG que contiene una u mayúscula blanca sobre un fondo rojo (llámalo granate, corinto, bermejo o carmesí; soy hombre, mi paleta RGB es muy limitada). Vamos a aumentar digitalmente (zoom digital) su tamaño hasta que se vean los píxeles de una zona determinada perfectamente (imagen central). Por último, la vamos a girar 45º en el sentido de las agujas del reloj (imagen derecha). Se aprecia perfectamente la pérdida de calidad obtenida.

Pérdida de calidad y pixelado

¿Y esto por qué sucede? Pues muy sencillo, porque los píxeles de una imagen son, en realidad, pequeños cuadrados perfectos con una información de color. Cuando una cámara digital capta una fotografía, en función de su resolución la divide en infinidad de píxeles de color que, todos juntos, forman la representación fotográfica. Como decimos, cada píxel es un cuadrado, cuyos lados están alineados, horizontal y verticalmente, con los bordes de la fotografía. Si giramos la imagen un ángulo que no sea múltiplo de 90º, el software ha de realizar una interpolación de píxeles para crear las nuevas líneas imposibles, ya que los cuadraditos que se llaman píxeles no se pueden girar. Por lo tanto, una línea que es recta y vertical ha que convertirse en una línea inclinada formada por diminutos segmentos horizontales y verticales.

Si a esto le añadimos un posterior guardado de la imagen en formato JPEG, estamos sumando pérdidas continuas.

Por supuesto que esto no se puede tomar como un dogma de «no gires nunca las fotos», sino como una curiosidad tecnológica que debe ser tomada en cuenta por aquellos que requieren la máxima de las calidades. Hoy día, con las cámaras actuales, nos movemos en unas resoluciones que apenas se resienten de los cambios, giros y guardados, sin embargo viene bien conocer cómo podemos sacarle el máximo partido fotográfico a nuestras imágenes.

Para evitar menoscabos, pues, podemos recurrir a trabajar con formatos sin pérdida de información, como puede ser el TIFF que permite, incluso, compresión sin pérdida alguna gracias al algoritmo LZW. Incluso un JPG abierto, girado y almacenado posteriormente como TIFF evitaría el perjuicio de la imagen. También muchos programas de retoque fotográfico permiten realizar giros sin pérdida en los archivos JPG, pues no llegan a guardar el archivo completo, sino que sólo modifican su cabecera para cambiar la orientación del mismo. Así también, muchas aplicaciones de software son capaces de leer los datos EXIF que las cámaras de fotos guardan con los archivos para mostrarlos correctamente en pantalla, y no todos horizontales.

Lo ideal sería utilizar el formato RAW, que es un modo digital que contiene la totalidad de los datos de la imagen, tal y como ha sido captada por el sensor digital de la cámara fotográfica, sin compresiones o con compresión sin pérdida. La pena es que este formato sólo lo manejan las cámaras profesionales y semiprofesionales, con lo que la inversión económica que debemos hacer es bastante mayor. Para la hora de visualizar estas imágenes y de tratarlas, tampoco podremos hacerlo con cualquier software del mercado, pues debe ser uno que soporte RAW de forma nativa. Aunque bien es verdad que la mayoría de las grandes aplicaciones de retoque del mercado ya lo hacen o, si no, podremos recurrir al propio software que siempre suelen incluir los fabricantes de las cámaras.

En fin, como dicen los profesionales de la fotografía, lo ideal es dedicar el máximo esfuerzo a la hora de tomar la imagen con la cámara, tanto en ángulo, posición, iluminación, matices, etcétera, dejando al proceso de retoque posterior un mínimo de trabajo o, a poder ser, nada. Pero claro, todos no somos expertos en estas lides, y yo el que menos.

Alice y Bob, una pareja tecnológicamente segura

Alice y Bob

Alice y Bob no son personas físicas reales sino personajes ficticios inventados para ser usados en las explicaciones criptográficas. Sus creadores (los mismos que asacaron RSA) los utilizaron por primera vez en el seminario que dio a conocer su algoritmo y, desde entonces, todos los profesionales relacionados con la materia hacen uso de sus nombres para explicar conceptos.

El tema es bien sencillo: los nombres se usan por convenio para evitar sentencias del tipo «la persona A quiere enviar un mensaje cifrado a la persona B». Los padres de Alice y Bob se dieron cuenta de que en una larga exposición donde personas A y personas B envían y reciben mensajes, los asistentes terminan por perderse con tanta letra para aquí y para allá. No hablemos entonces si en el discurso se introducen nuevos elementos C, D, E y etcétera. El lío es monumental.

Sin embargo, está demostrado que utilizando Alice (A) y Bob (B), el público enseguida relaciona en sus cerebros dichos nombres con caras de personas (mujer y hombre), haciendo más sencilla y comprensiva la disertación. Es algo así como procurar enseñar a un niño a sumar con canicas o cochecitos de juguete en lugar de utilizar números, un concepto asaz abstracto para sus recién estrenadas neuronas.

Alice y Bob son tan famosos y reconocidos en el mundo de la seguridad informática que el propio profesor Andrew S. Tanenbaum (una eminencia en estos campos), en su libro ‘Redes de computadoras‘, cuenta que si escribes algo sobre criptografía y utilizas otros nombres, es bastante probable que nadie se tome en serio lo que dices.

Existen multitud de nombres de actores secundarios que han ido surgiendo al calor de Alice y Bob. Y es que, en ocasiones, es necesario recurrir a un mayor número de agentes implicados en las comunicaciones. Así pues, podemos destacar a Carol (o Charlie) como tercer participante principal (la persona C), a Dave (persona D) como cuarto participante, a Craig como el password cracker o a Eve como eavesdropper (la atacante en modo escucha).

Esta pareja es tan cercana a los entendidos en criptografía que, incluso, han aparecido numerosos chistes acerca de ellos. Un buen ejemplo es el que sigue:

¿Cuál es el colmo de un criptógrafo? Que su mujer se llame Alice, que ella tenga un amante que se llame Bob y que el hombre no entienda nada de lo que se cuentan en sus cartas.

También otros más elaborados y que no hay Dios que los entienda porque, además de estar en inglés, hay que ser un friqui de la criptografía para saber dónde está la puñetera gracia.

Alice y Bob representan una pareja inseparable, con una comunicación muy fluida y segura a prueba de extraños y terceras personas. Los amantes más tecnológicos que hayamos conocido nunca. Una historia de amor indescifrable.

Por cierto, este hecho de inventar personas y personajes no es privativo de la informática. En el mundo de la radio tienen a Dave y Sue, en el teatro americano a George Spelvin y en la Armada Británica a Tommy Atkins, entre otros.

GNU/Linux sigue adoleciendo de facilidad de uso

Tux, i love u, but...

Ayer se murió mi portátil grande (de tamaño). Era un Acer chungo que tenía veinte mil años y, la verdad, había pasado por millones de batallas, formateos, cambios de hardware, añadidos varios y más putadas. El ordenador es viejo y, para más ende, con teclado en portugués y una tarjeta WiFi en placa que funcionaba a veces no y a a veces tampoco. El pobre había sufrido un inmejorable Windows XP durante todo este tiempo.

Bueno, muerto eres, se acabó; te desgracio vivo y, ya de paso, te voy a meter la última distro de Ubuntu para que te pongas bonito y me dejes tirar unos cuantos años más contigo, aunque sea para lo básico, que no necesito más de ti, corazón.

Me descargo la última versión de Ubuntu, la quemo en un cedé y me la llevo al aparato. Arranco y se inicia la instalación; todo correcto al más mínimo detalle. Configuro las particiones de root, home y swap con sus respectivos sistemas de archivo, asigno el espacio, determino mi configuración de teclado, configuro el nombre de la máquina y, también, el de usuario y su contraseña correspondiente. El tema va a las mil maravillas.

De pronto, sucede algo inesperado: tras completar la instalación, el ordenador no arranca, se queda atontado, sin decir nada y con la pantalla negra y un bonito cursor pixelado parpadeando en monocromo. ¿Qué demonios?

Instalo el sistema una, dos y hasta tres veces más, cambiando configuraciones y variando asignaciones de espacio, sistemas de archivo, particionados, etcétera. Nada de nada; sigue haciendo lo mismo, se me queda colgado en un arranque normal, en modo depuración y hasta haciendo el test de memoria. ¡Qué cosa más rara! Esto va a ser la tarjeta wireless que va mal y me bloquea el proceso: la desactivo, pero todo sigue igual.

Llegó un momento en que mis conocimientos no daban más de sí. Es posible que siendo un gurú en temas de hardware, controladores y configuraciones linuxeras habría podido solventar el asunto de una manera más que elegante, pero no todos aquellos que nos sentamos delante de un ordenador tenemos que conocer los entresijos del kernel del sistema, la herencia de ensamblados que necesitan los aparatos para funcionar o las librerías necesarias para hacer correr un determinado controlador.

La solución fue harto sencilla, a la par que frustrante: instalar una versión de prueba de Windows 7 que ruló de perlas desde el primer cuadro de diálogo de instalación hasta la última actualización del sistema. Y esto es lo que no me parece lógico y normal.

Si GNU/Linux se quiere comer una buena porción de la tarta de chocolate que representan los sistemas operativos actuales, tiene que hacer de tripas corazón y asumir que el mercado casero informático no está dispuesto a lidiar con negras consolas de texto, compilaciones de paquetes de instalación o rutas de acceso imposibles. El hecho de una mayor robustez, una seguridad inmejorable y un precio nulo no va a ser nunca una buena baza a favor para la gente de a pie. No todos aman el software libre, algunos quieren no volverse locos para instalar un programa descargado de Internet. Como decía Bill Gates en sus tiempos mozos, «que lo tuyo sea mejor no importa, ¿no te das cuenta?».

Cómo se autodestruye un JPG

Pérdida de calidad sucesiva

El algoritmo de compresión JPEG se basa en dos defectos visuales del ojo humano. El primero de ellos es el hecho de que nuestro ojo es mucho más sensible al cambio en la luminancia que al de la crominancia, es decir, que capta más claramente los cambios de brillo que de color. El segundo se refiere a que percibimos con más facilidad pequeños cambios de brillo en zonas homogéneas que en áreas donde la variación es grande, por ejemplo en los bordes de los cuerpos de los objetos.

No es raro que los métodos de compresión con pérdida utilicen deficiencias en los sentidos del ser humano. Por ejemplo, el archiconocido formato de compresión de sonido MP3 se sirve de las imperfecciones del oído de las personas para eliminar toda aquella información acústica que no somos capaces de percibir (oír, en este caso).

Esa forma de trabajar que tiene el algoritmo de compresión de JPEG hace que la pérdida de calidad, cuando se realizan sucesivas compresiones, sea acumulativa. Esto es, el simple hecho de abrir un fichero JPG y, sin realizar cambio alguno, guardarlo de nuevo, revierte en una pérdida sustancial de la información del archivo. Cuantas más veces se realice el proceso, más cantidad de información se pierde, llegando a obtenerse, con el paso del tiempo, un archivo objeto totalmente desfigurado y diferente al archivo origen.

La manera de comprobar esto es muy sencilla. Tomemos un archivo JPG cualquiera, lo abrimos con un software de edición de imágenes y lo guardamos, simplemente. Volvemos a guardar, volvemos a guardar y volvemos a guardar. Repetimos este proceso cien veces y, al final, comparamos el último fichero con el primigenio. La diferencia ha de ser notable.

El problema es que la mayoría de los programas profesionales de edición no permiten guardar si no ha habido cambios en el lienzo. Así que el procedimiento se puede convertir en algo eterno, pues habría que cerrar y volver a abrir o, en su caso, hacer algún cambio y deshacerlo (mover la imagen un píxel a la izquierda y otro a la derecha, por poner un ejemplo).

Si queremos ahorrarnos el tiempo de hacer esta prueba, podemos visionar el siguiente vídeo, donde se aprecia la progresión de deterioro ocasionado al abrir y guardar una misma imagen JPG 600 veces seguidas.

Sucesiva pérdida de calidad de un archivo JPG

Como decíamos, pues, la pérdida es acumulativa. Cada vez que guardamos un archivo JPG el algoritmo de compresión actúa eliminando información del archivo previo. Si se comprime una imagen y se descomprime, se perderá calidad de imagen, pero si se vuelve a comprimir una imagen ya comprimida se obtendrá una pérdida todavía mayor. Cada sucesiva compresión causará pérdidas adicionales de calidad. La compresión con pérdida no es conveniente en imágenes o gráficos que tengan textos, líneas o bordes muy definidos, pero sí para archivos que contengan grandes áreas de colores sólidos.

Con pocos guardados de imagen, la diferencia no es perceptible por el ojo humano, sin embargo, se recomienda no trabajar directamente sobre imágenes JPG en el proceso de edición, sino utilizar otro formato (normalmente el nativo de cada software de retoque) para, al final, convertir y comprimir como JPEG. Que lo sepas.