teknoPLOF! se muda

Estamos de mudanza

teknoPLOF! está de mudanza. Nos hemos trasladado a este bonito .com, así que vete actualizando tus favoritos, tus feeds RSS y todo lo que tengas que actualizar, porque el blog antiguo dejará de funcionar en unos días.

Espero que te encuentres a gusto en este nuevo entorno y que sigas disfrutando de los post como lo hacías hasta ahora. Es probable que veas cambios o cosas raras mientras dure la fase BETA del blog, sé paciente y entiende el trabajo que le cuesta a este pobre bloguer el hecho de cambiar de un sitio a otro.

Se han migrado todas las entradas y todos los comentarios, por lo que encontrarás aquí todo lo que había allí, sin faltar una miajita.

Un saludo a todos y a todas, y gracias por vuestra fidelidad.

Reseña web: Aseguring

Aseguring

Un buena idea, un diseño impecable y un funcionamiento perfecto pueden convertir una web de un día para otro en un bombazo internetero de calibre desmesurado. Y es eso precisamente lo que ocurrirá con Aseguring, un sitio web de esos que dices «¿por qué demonios no se me habrá ocurrido a mí?». Pues lo siento, ya se te han adelantado.

Aseguring es un comparador de seguros en principio preparado para turismos y motocicletas, pero que en breve ampliará su cobertura a seguros del hogar. Trabaja con un montón de aseguradoras y, como comparador que es, se dedica precisamente a eso, a comparar. En no más de 3 minutos se puede obtener una comparativa de precios de las compañías más representativas del sector.

Esta herramienta ahorra un tiempo (y dinero) increíble a todo aquel que, antes de contratar un seguro, desea obtener un presupuesto detallado de todas y cada una de las compañías, permitiendo compararlos entre sí. ¿Y cuánto me van a cobrar por el servicio? ¡Uf!, una pasta: nada. Sí, sí, nada. Es un servicio totalmente gratuito y completamente imparcial e independiente, porque no depende de ninguna aseguradora.

Además Aseguring incluye una evaluación de las principales coberturas de todas las pólizas y las clasifica mediante un completo sistema de valoración que muestra la calidad de las prestaciones, de forma que se dispone de una información más que valiosa a la hora de contratar un seguro. Otra ventaja añadida es la opción de seleccionar los productos que resultan más interesantes y comparar sus coberturas en una misma pantalla.

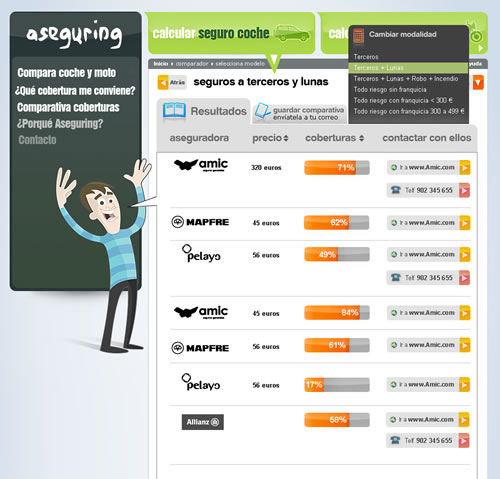

Resultados

Sin olvidarnos del simpático consejero, un personaje que aconseja qué producto contratar dependiendo del perfil del contratante y del vehículo que se desea asegurar.

El manejo es ultrasencillo. Basta con seguir los distintos pasos, de una manera muy intuitiva y por medio casi exclusivo de clics de ratón, introduciendo los datos del coche o moto, los datos del conductor y los de tu seguro actual (ninguno de estos datos es personal o sensible, sólo los necesarios para completar la contratación de un seguro). Automáticamente la herramienta te muestra las distintas modalidades de seguro que puedes contratar, ofreciéndote una de ellas como opción recomendada por Aseguring.

El paso siguiente es la conexión con las aseguradoras para recabar datos y calcular precios. El proceso ha terminado y ya sólo queda ver las tarifas, las valoraciones y, si se desea, las coberturas particulares de cada compañía para el seguro elegido o una comparativa de coberturas entre dos o más compañías. Aquí también se nos ofrece la posibilidad de contratar el seguro, vía web o por teléfono, contactando con la aseguradora en cuestión. Lo mejor de todo es que te proporcionan un número de referencia para que, si deseas contratar el seguro, no tengas que proporcionar de nuevo todos los datos introducidos. Simplemente genial.

Comparar seguros

La recomendación de teknoPLOF! es que inviertas unos minutos en probar el comparador para analizar las ofertas del mercado y compararlas con tu seguro actual, tanto a nivel de precios como a nivel de coberturas. Basándote en eso podrás determinar tu potencial de ahorro anual (ahorrando 150 euros al año durante la vida media de un vehículo de 8 años supondría un ahorro total de ¡1.200 euros!) y ponerte en contacto fácilmente con la aseguradora que más te interese.

En fin, herramientas como Aseguring son las que dan poder e información útil al consumidor. Olvídate de las interminables horas al teléfono solicitando presupuestos, o del tiempo de navegación que pierdes de web en web de cada compañía rellenando formularios. ¡Lo puedes hacer en tres minutos desde www.aseguring.com!

Además mola rellenar todo como si fueras un kamikaze de la carretera (tengo un Audi, dieciocho años, cientos de partes a mi compañía, uso el coche a diario y hago miles de kilómetros, además lo van a conducir otros seis amigos míos, etcétera) y ver como te sale un cartelito que te dice que ninguna compañía tiene los suficientes arrestos para asegurar a un capullo como tú.

WiMAX: la que se nos iba a venir encima. Pues no, oiga.

WiMAX

WiMAX son las siglas en inglés de Interoperabilidad Mundial para Acceso por Microondas (Worldwide Interoperability for Microwave Access). Es una tecnología de conexión parecida al WiFi que todos ya conocemos pero a lo bestia. WiMAX ofrece mayor ancho de banda y mayor alcance, lo que permite crear redes inalámbricas metropolitanas y, lo más importante, con una inversión ridícula con respecto a lo que representa como avance tecnológico. Además, está respaldada por las empresas más importantes del sector, que siempre ayuda.

WiMAX es el protocolo estandarizado como IEEE 802.16 para la conectividad que permite la recepción por microondas y retrasmisión por ondas de radio. El único organismo habilitado para certificar el cumplimiento del estándar y la interoperabilidad entre equipamiento de distintos fabricantes es el Wimax Forum; todo equipamiento que no cuente con esta certificación no puede garantizar su interoperabilidad con otros productos. La tecnología WiMAX podría ser la base de las redes metropolitanas de acceso a Internet, sirviendo de apoyo para facilitar las conexiones en zonas rurales y utilizándose en el mundo empresarial para implementar las comunicaciones internas. Asimismo, su popularización puede suponer el despegue definitivo de otras tecnologías, como VoIP (llamadas de voz sobre el protocolo IP), debido a su amplio ancho de banda.

Según las especificaciones es capaz de conseguir una velocidad de 70 Mb por segundo (hasta 300 Mbps full-duplex) y de cubrir un área de unos 50 Km a la redonda con una sola antena. Teniendo en cuenta que WiFi llega a 300 metros con un poco de suerte y el viento a favor, y que su ancho de banda oscila entre 11 Mbps y 54 Mbps, dependiendo de la modificación (a/b/g) del estándar, pues queda meridianamente claro que WiMAX se convertirá en el futuro de las comunicaciones inalámbricas. Si es que no se lo carga antes alguna mano negra, claro.

Un sistema WiMAX con seis puntos de acceso podría dar cobertura de 360º para 1.200 abonados, con un coste de unos 6.000 €. La diferencia de costes es evidente, ya que otros sistemas llegan a suponer la friolera de 96.000 € para una red de 500 abonados.

La infraestructura de WiMAX consta de varias partes claramente diferenciadas. Por un lado tenemos las antenas-torre o estaciones base, con capacidad para ofrecer cobertura hasta 8.000 Km2 a frecuencias del orden de 66 GHz. Al abarcar tanta distancia, se hace necesario, a veces, que existan antenas intermedias que operen en bajas frecuencias (entre 2 y 11 GHz) con el fin de evitar las interferencias ocasionadas por la presencia de elementos. Estas antenas tienen un área de cobertura de 65 Km2, lo que viene a ser, más o menos, el radio de acción de las antenas de telefonía móvil. Por último tendríamos el elemento de red de nuestros equipos, es decir, la tarjeta WiMAX que recibe la señal.

Los usuarios finales recibimos la señal de las antenas de baja frecuencia, con un ancho de banda considerable y una cobertura impresionante. Además, y como ocurre con los teléfonos celulares, podríamos desplazarnos en un estado conectado permanente sin perder la conexión, incluso aunque saliéramos de la zona de cobertura o hotspot, ya que automáticamente entraríamos en otra área cubierta y la transición de una a otra se realizaría de manera transparente al usuario debido al solapamiento entre zonas.

Actualmente se recogen dos variantes dentro del estándar 802.16, el modelo fijo y el de movilidad completa. El acceso fijo (802.16d) establece un enlace de radio entre la estación base y un equipo situado en el domicilio del usuario. Para este entorno fijo las velocidades teóricas máximas que se pueden obtener son de 70 Mbps con un ancho de banda de 20 MHz. Sin embargo, en entornos reales se han conseguido velocidades de 20 Mbps con radios de célula de hasta 6 Km, ancho de banda que es compartido por todos los usuarios de la célula.

El modelo de movilidad completa (802.16e) permite el desplazamiento del usuario de un modo similar al que se puede dar en redes de móvil GSM/UMTS.

Como ya se ha mencionado, las expectativas de WiMAX se extienden también a sitios rurales con poco acceso, es decir, a todas aquellas personas a las que el ADSL y el cable les queda fuera de alcance y buscan soluciones para poder trabajar desde sus hogares o centros de trabajo. Pero también es muy importante en las ciudades y localidades más céntricas. Actualmente disponemos de una conexión por cable (par telefónico, fibra óptica, etcétera) que llega a nuestras casas hasta un router o un módem, y es este aparato el que se encarga de distribuir la señal inalámbrica (WiFi) por el resto de nuestro hogar para llegar a un portátil, un pocket PC o una videoconsola. Con WiMAX la señal inalámbrica llega directamente a nuestra casa (lo que se conoce como «la última milla») por el aire, y son los distintos aparatos y gadgets los que, por medio de una tarjeta de red adecuada, se conectan directamente. Los proveedores de acceso a Internet dispondrían, pues, de esta posibilidad para ofrecer el servicio sin necesidad de utilizar instalaciones de cables. Nos mandan Internet por las nubes, como si de una red WiFi gigantesca se tratase.

Con semejante ancho de banda, velocidad y cobertura, los diseñadores de aplicaciones y tecnologías que necesitan «mucha chicha» para funcionar se frotan la manos. El VoIP, la tele por Internet, el cine online, retrasmisiones en riguroso directo, todo ello es posible gracias a WiMAX. Las compañías de telefonía móvil tiemblan, y es que el despliegue de WiMAX podría utilizarse también como alternativa a las redes telefónicas, ya que un móvil o un ordenador conectado a WiMAX podría hacer llamadas de telefonía IP sin coste añadido y con disponibilidad de una completa movilidad. Además esta tecnología soporta las denominadas antenas inteligentes, que emiten un haz estrecho que puede ir moviéndose para enfocar siempre al receptor, evitando así interferencias. Factores asaz importantes para competir de plano con la telefonía 3G.

Como digo, las operadoras tradicionales de Internet y de telefonía móvil ven a WiMAX como un claro competidor amenazando con total impunidad a sus ADLS, sus GSM, sus GPRS y sus UTMS. WiMAX podría hacerse con el mercado de la última milla (WiMAX atraviesa el hormigón, UMTS se desvanece con la niebla) dejando con un palmo de narices a todas esas empresas que tanto se afanaron (y afanan) en tirar cable y cable hasta la saciedad. Y ahí es donde veo yo el peligro, ahí es donde podría aparecer una mano negra que consiga que esto no llegue a buen puerto y dé con sus especificaciones en el fondo del mar. Matarile, rile, rile.

En España ya suministran WiMAX operadores como Iberbanda, Broadnet o Neosky. En Euskadi existen implementaciones, experimentales y comerciales, en el 90% del territorio, y Euskaltel dispone de varios cientos de abonados WiMAX en zonas rurales (el Gobierno Vasco ofrece subvenciones de hasta el 100% de la instalación). En Andalucía, Madrid, Murcia, Comunidad Valenciana, Galicia y otros lugares ya disponen de WiMAX en mayor o menor medida.

Pero, ¿por qué no despega esto de una vez por todas? Nokia y Samsung anunciaron hace años la aparición inminente de teléfonos móviles preparados para WiMAX (no quieren perder tajada) y, efectivamente, estos terminales existen, pero como la red no es un algo muy extendido, no sé dónde los estarán vendiendo. Al menos en España no pita o no lo dejan que pite. En Corea, por ejemplo, llevan desde el año 2006 utilizándolo masivamente son dispositivos de Samsung, Intel y otros fabricantes.

Según previsiones antiguas se esperaba que WiMAX creciera un 70% en cinco años. ¿Lo veremos realmente? Llevo escuchando hablar de WiMAX desde mediados del año 2005, más o menos, y no veo que los responsables se interesen mucho por su implantación, a excepción de en entornos rurales alejados. ¿Por qué se oferta cada vez más ADSL y cable módem si, en teoría, son tecnologías sentenciadas a la desaparición? Somos los últimos en Europa, y de los del vagón de cola en el mundo, en la implantación de WiMAX y esto no me huele nada bien. No, no. Todo esto me suena mucho, pero mucho, a la trayectoria del formato de vídeo Betamax que Sony presentó en los años setenta, o la del LaserDisc, o la del MiniDisc, o a la…

Neutralidad de Internet para torpes

Justicia neutral

Últimamente estamos oyendo parlotear mucho acerca de la tan manida neutralidad de Internet. Hizo alusión a ello el presidente de EEUU, Barack Obama, en su campaña electoral, y el pasado mes de junio, Julius Genachowski, presidente de la FFC (Comisión Federal de las Comunicaciones) estadounidense, volvió a sacar el tema a la palestra con sus declaraciones. El amigo Julius prometió presentar unas bases para regular esto de la neutralidad en la Red de Redes.

Pero, ¿qué demonios es eso de la neutralidad de Internet? ¿No es Internet neutral? Pos no, mirusté. Matizo, Internet sí es neutral, los que no lo son, son aquellos que proporcionan el servicio, es decir, los ISP o Proveedores de Servicios Internet.

El problema de la neutralidad de la Red es muy sencillo: algunos ISP bloquean o retardan conexiones de sus usuarios por causas como un elevado ancho de banda o conexiones con servicios de la competencia. Lo explicó ahora pa’ la señá María, que no se ha enterado todavía. Usted, señora, tiene el Intenné este de Telefónica en casa, ¿verdad? Bueno, pues imagínese que la empresa le bloqueara la conexión cuando usted se conecte a la web de Vodafone. ¿Por qué? Por joder; es la competencia.

Esta práctica está empezando a ser demasiado común entre los proveedores de acceso, si bien en España parece que no ocurre con demasiada frecuencia. Si detectan que un usuario consume un elevado ancho de banda por estar conectado, por ejemplo, a una red peer to peer descargando una película de Gracita Morales, pues le cortan el servicio o se lo ralentizan. (Y no precisamente porque la película sea de Gracita Morales).

Hace un año, el operador argentino Fibertel y la multinacional Google llegaron a un acuerdo por el cual los usuarios de este ISP podrían acceder más rápido a GoogleEarth, GMail y Youtube, implementando un enlace privado entre Fibertel y Google e instalando servidores locales de Google en el datacenter de la empresa argentina. Oséase, lo que viene siendo de todo punto una patada en los mismísimos huevos al principio de neutralidad de la Red que, por cierto, el gigante buscador de Internet defiende con vehemencia a través de la figura de Vinton Cerf. Cuando un proveedor de contenidos goza de una red «particular» y diferente a la de sus competidores se destroza literalmente el campo de igualdad que permitió que todas las startups que hoy conocemos nacieran y crecieran en su día.

Cierto es también que, días después, Google emitió un comunicado en el que desmentía estas afirmaciones y culpaba a una nota de prensa mal redactada en la que ellos no tomaron parte y con la que no estaban de acuerdo, y que si la abuela fuma, que si deja de fumar, que patatín o patatán. Bueno, le concedemos el beneficio de la duda por ser vos quien sois.

Hace año y pico, también, la FCC sentenció al proveedor de Internet Comcast por violar una norma federal al bloquear las transferencias de algunos usuarios procedentes de redes BitTorrent. El fallo obligó a los proveedores de servicios a modificar la forma en la que gestionaban su red, así como a garantizar a sus usuarios un acceso abierto a Internet.

En la web www.neutralidadsi.org han realizado diversas pruebas con resultados positivos que acusan a VTR, uno de los principales actores de la banda ancha en Chile, de colocar restricciones de cuello de botella a las conexiones realizadas a través del puerto 6881, puerto por defecto para la red BitTorrent.

El Gobierno estadounidense de Obama quiere formar parte activa de esta controversia. La neutralidad de Internet es el principio que dice que todo el tráfico que circule por la Red debe ser tratado igual, independientemente de qué tipo sea y de su origen y destino. Por ello plantearon en el pasado mes de octubre algunas normas para prohibir a los proveedores de acceso discriminar los servicios, contenidos y aplicaciones que consuman más ancho de banda, como por ejemplo el vídeo, e impedirles bloquearlo o lentificarlo. La FCC defendió las normas como indispensables para crear un Internet abierto y democrático. Las medidas propuestas prohíben a los proveedores de ancho de banda «impedir que los usuarios envíen o reciban material legal de su elección» y «dificultar a los usuarios el poder de elegir entre la competencia de proveedores de redes, aplicaciones, servicios y contenido» y, sobre todo, se les obliga a «tratar contenidos, aplicaciones y servicios legales de forma no discriminatoria».

Existen también voces en contra de la neutralidad, como no, pero pueden todas ellas resumirse en las palabras que en Libertad Digital escribió el ingeniero Fernando Herrera. Dijo textualmente:

Hay bits más importantes que otros bits, por la clase de información que llevan o por la urgencia de la misma, o porque si no llegan de una determinada forma son inútiles. Los operadores siempre han tenido mecanismos para gestionar la Red, lo que en definitiva significa priorizar unas comunicaciones frente a otras, para que funcionen de forma adecuada los servicios que se prestan.

Además decoró su disertación con este bonito paralelismo

La igualdad de bits sería como la igualdad de vehículos en nuestras carreteras. Impediría a las ambulancias y bomberos cumplir su función en muchos casos. Las sirenas son el mecanismo de priorización en las vías de tráfico, y a nadie se le ocurriría eliminarlas, mucho menos en aras de un supuesto derecho de los ciudadanos.

Vamos, el colmo de la demagogia. Está claro, señá María, que el correo diario que le manda usted a su hija la que estudia en Niuyor es menos importante que los correos que mandan otras personas más importantes que su persona. Y es que, le guste o no, usted no deja de ser una mujer de pueblo tonta y boba a la que hay que educar. ¡Déjese manejar, señora, y evite pensar por usted misma! Y, por supuesto, no se le ocurra descargar canciones de Manolo Escobar con el burrito ese tan bonito de al lado del reloj, que se le bloqueará hasta la factura del gas; ¿no comprende usted que son más importantes las conexiones a páginas guarras de nuestros políticos en el hemiciclo?

Uno de los padres de Internet, Vinton Cerf, actualmente Vicepresidente Mundial y Chief Internet Evangelist de Google, cree que la neutralidad de la Red es fundamental para preservar nuestras libertades, que «Internet fue diseñada sin ningún guardián sobre nuevos contenidos o servicios.»

Además, Enrique Dans publicó no hace mucho en su blog el «quién es quién» de la neutralidad en la Red y dejó caer, como quién no quiere la cosa, quiénes son los hinchas y a qué equipo animan. Por poner algún ejemplo, los amigos de la neutralidad son empresas como Google, eBay, Mozilla, Amazon, Twitter, Sony o Vuze; los enemigos, compañías como Cisco, Alcatel-Lucent, Cornig, Ericsson, Motorola y Nokia, entre otros.

A veces uno no sabe si te están diciendo la verdad o todo es una puñetera estrategia de empresa. El miedo que tengo es que si los políticos se ponen cabezones al final siempre hacen lo que les da la gana, y encima nos hacen creer que es por nuestra culpa y por nuestro bien. Corderitos cibernéticos manejados por la soga del ancho de banda. ¡Beeee!

Captcha: Escribe el código de la imagen, si puedes…

Captcha

¿Quién no se ha tropezado, a la hora de registrarse en un sitio web, con el estúpido cuadro de texto en el que debemos escribir el código de letras y números que aparece en una imagen anexa? ¿Quién no se ha ciscado tres veces en la madre que engendró al que inventó esta chorrada porque es incapaz de vislumbrar siquiera alguno de los caracteres de la mencionada imagen?

Este sistema para autenticar que usuarios humanos y no programas o robots o spambots están tecleando delante del ordenador sus datos a la hora de realizar un registro es, sin quedarme corto, la mayor de las gilipolleces que los lumbreras de este mundo digital han asacado tras exprimir al máximo sus binarios cerebros.

Captcha es un acrónimo de Completely Automated Public Turing test to tell Computers and Humans Apart, uséase Prueba de Turing pública y automática para diferenciar computadoras y humanos. Es un sistema inventado para determinar que el que está rellenando determinado formulario es una persona física humana terrestre del mundo mundial y no un programita informático que se dedica a, por ejemplo, darse de alta automáticamente en foros de noticias y llenarlos de spam y mensajes para comprar Viagra hasta que revienten.

La idea es buena, el resultado un asco. Proviene, como su nombre indica, del archiconocido Test de Turing, pero con una pequeña gigantesca diferencia, que es que en la prueba de Turing el que debe determinar si le contesta una máquina o un ser humano es otro ser humano, y no un programa informático.

El Test de Turing pretende demostrar la supuesta inteligencia de una máquina. Se supone un juez situado en una habitación y una máquina y un ser humano en otra. El juez debe descubrir cuál es el ser humano y cuál es la máquina, estándoles a los dos permitido mentir al contestar por escrito las preguntas que el juez les hace. La tesis de Turing es que si ambos jugadores son suficientemente hábiles, el juez no podrá distinguir quién es el ser humano y quién la máquina. Hasta hoy, gracias al Cielo, ninguna máquina ha conseguido superar esta prueba.

Supongamos por un momento que queremos registrar nuestra página güeb en un buscador o motor de búsqueda internetero. Sabemos que existe software especializado para realizar esta función en millones de buscadores a lo largo y ancho de la Red de redes de un solo plumazo. Tocotó. Clic, clic y clic y ya tengo mi paginita en todos los buscadores del mundo. Pos no.

Parece ser que estos programitas les repatean las gónadas sexuales a los dueños de los buscadores, porque ellos lo que quieren es que tú entres en su web, te recorras seiscientas páginas hasta encontrar la del alta de sitios nuevos y teclees los datos con esmero y pulcritud en sus bonitos formularios hachetemele. Es por ello que anulan de un brochazo la posibilidad de utilizar software especializado cascándote un cuadro de texto con una imagen a su lado en la que se reflejan una serie de caracteres que, de manera aleatoria, cambian cada vez que accedes a esa página. Evidentemente los programas que ejecutan registros no pueden leer estos caracteres porque forman parte de una imagen prediseñada.

Esta técnica comenzó de este modo y ahora se ha extendido a cualquier página de todo pichichi que cuelga un formulario en el Intenné. Que quieres formar parte de mi peña de futbolín, pues te registras pero me rellenas la casillita de marras con los caracteres de la imagen; que lo que quieres es darte de alta en mi página de coleccionistas de bigotes de foca, pues ídem majete, a ver si van a inventar un programa que registra automáticamente usuarios en páginas de coleccionistas de bigotes de foca y se me va a terminar el chollo de que navegues a gusto por mi web recién horneada.

Si partimos de la premisa de que el sistema es válido para la función que realiza, aunque vulnerable sin no mucha inteligencia programática, yo me pregunto por qué demonios las letras y números de las imágenes de las pelotas no están más claros y mejor escritos. Qué más dará, digo yo, que una «I» parezca un «I», como tiene que ser, o que parezca un «i» o una «L» o una «l» o un «1».

Pues nada, exactamente, da igual hacerlo bien que mal. Entonces, ¿por qué cojones no ponemos las cosas más fáciles al usuario y empezamos a hacerlo bien? Supongo que pensarán que se pueden aplicar complicadísimas técnicas OCR para que un software descifre las letras y tal. Hombre, por favor. Hay imágenes prácticamente indescifrables a golpe de ojo humano (como la del afoto adjunto) y algunas que dan tanto por el culo que entran ganas de mandar al mismo lugar corporal al que inventó la gilipollez ésta, al güebmaster, al dueño de la página y la madre que los parió a todos.

El problema es que los diseñadores web se creen que esto es seguro, pero nada más lejos de la realidad. Actualmente hacer un captcha seguro requiere métodos complicados de implementar que únicamente poseen las grandes empresas. Cualquier algoritmo que se le aplique a una imagen puede ser desalgoritmado en cero coma. Que si tachan las letras, que si las deforman, que si utilizan la misma gama de colores para el frente y el fondo… Na de na. La ingeniería inversa deshace todo aquello antes hecho, y más teniendo en cuenta que los algoritmos de los captcha son públicos,… ¿qué más quieres?

Aunque los captcha fueron originalmente diseñados para impedir que un software OCR reconozca los caracteres de las imágenes generadas, existen proyectos de investigación que han probado que es posible saltarse muchos de estos engendros con programas que han sido específicamente diseñados para un tipo determinado de captcha. Para los que tienen letras distorsionadas, por poner un ejemplo, la aproximación típica es seguir los siguientes pasos:

- Eliminación del ruido de fondo, por ejemplo con filtros de color y detección de líneas finas.

- Segmentación, por ejemplo partiendo la imagen en segmentos que contienen una sola letra.

- Identificar la letra de cada segmento, y así utilizar la información extraída de la imagen.

El paso 1 es típicamente muy fácil de automatizar. Además, en 2005, se mostró que un algoritmo de una red neuronal tiene un menor margen de error que los humanos resolviendo el paso 3.

La única parte dónde los humanos superan a las máquinas es en el paso 2. Si el ruido de fondo consiste en formas similares a letras, y las letras están unidas a este ruido, la segmentación se hace casi imposible con el software actual. Por lo tanto, un captcha efectivo debería enfocarse en el paso 2, la segmentación.

Otros captcha son vulnerables por múltiples factores, ya que algunos sisitemas pueden sortearse simplemente reutilizando el ID se sesión de una imagen conocida y cascándolo en la URL a la hora de acceder a la page en cuestión; otros se alojan en servidores compartidos; otras veces, si parte del software de generación del captcha se realiza en el lado del cliente (la validación se hace en el servidor, pero el texto que el usuario tiene que identificar es renderizado en el lado del cliente), los usuarios pueden modificar el cliente para que muestre el texto sin renderizar. En fin.

Además de todo ello, siempre queda el recurso de la mano de obra barata, usando humanos explotados para decodificar los captcha. Un documento de la organización W3C afirma que un operador «puede fácilmente verificar cientos de ellos cada hora».

En fin, que hoy en día estoy viendo por ahí métodos de autenticación mucho más fiables e ingeniosos (como las operaciones matemáticas o las definiciones de términos y palabras) que los captcha estos de los cojones. Así que déjennos en paz con cartelitos ilegibles y paren de poner trabas a la hora de navegar. Esto viene a ser las barreras arquitectónicas del Internet de futuro.