Entradas de la categoría ‘Tecnologías varias’

La impresora que secuestra conversaciones de teléfono

Stealth Cell Tower

Julian Oliver es un artista e ingeniero neozelandés (afincado en Berlín) que, durante años, ha tenido la extraña obsesión de intentar detectar torres telefónicas ocultas, esas gigantescas antenas de carretera –profusas en muchos lugares del mundo– cubiertas de falsas hojas para hacerse pasar por un árbol o, incluso, ocultas como postes de farolas o falsas astas de bandera. Esta afición suya le dio un idea algo traviesa, ¿qué ocurriría si fabricara una torre telefónica, perfectamente disfraza de impresora láser, que descansara en una oficina y fuera capaz de secuestrar conversaciones y mensajes de teléfonos móviles? Pues lo hizo.

Tras meses de estudio y trabajo, Oliver presentó el resultado de su obra, una aburrida impresora láser de Hewlett Packard que era capaz, secretamente, de funcionar como una estación GSM maliciosa, engañando a los teléfonos a su alcance para que se conecten a ella en lugar de a la torre se su operador telefónico, interceptando llamadas y mensajes de texto.

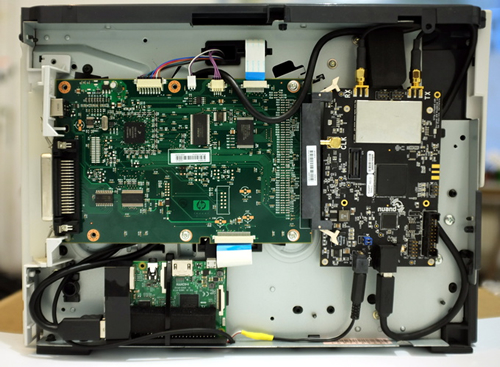

Stealth Cell Tower por dentro

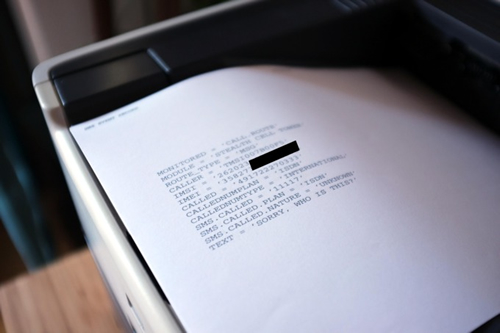

Las pruebas fueron totalmente satisfactorias, y la falsa impresora, a la que su diseñador llama Stealth Cell Tower, pudo acceder a las llamadas de voz y a los mensajes SMS de los trabajadores de una oficina. Sin embargo, este periférico no pretendía espiarlos, como muchas torres reales al aire libre sí hacen, sino que simplemente iniciaba una conversación de mensaje de texto con el teléfono interceptado, fingiendo ser un contacto no identificado, mediante un mensaje genérico como «Ven cuando estés listo» o, más juguetón, «Estoy imprimiendo ahora los detalles para ti». Si la víctima, confundida, respondía al mensaje, la impresora escupía su respuesta en papel como una espeluznante prueba de concepto.

Mensajes SMS a las víctimas

Además, también está programada para hacer llamadas a los teléfonos conectados y, si el propietario osa contestar, el aparato reproduce un archivo de audio con la canción de Stevie Wonder ‘I just called to say I love you’. Tras cinco minutos, se desconecta del abonado y le permite reconectarse a una torre de telefonía celular real.

La creación de Oliver no tiene la intención, simplemente, de organizar una elaborada broma de oficina, sino que pretende demostrar los defectos inherentes a la privacidad de las conexiones celulares de las cuales dependen nuestros teléfonos móviles. Después de todo, su Stealth Cell Tower no es nada diferente de los dispositivos conocidos como captadores IMSI que la policía de medio mundo utiliza para secuestrar conexiones de teléfonos móviles o espiar y rastrear a sospechosos de delitos. La impresora de Oliver debe servir como un recordatorio para que el, tan manido hoy día, cifrado de extremo a extremo en las comunicaciones sea una realidad global. Julian, por supuesto, recomienda que la aplicación de cifrado sea libre y de código abierto. «Mi proyecto está intencionalmente construido para humillar a GSM», dice Oliver. «GSM está roto, y necesitamos cifrar nuestras comunicaciones de extremo a extremo».

Impresión de datos de la víctima

Julian Oliver construyó su impresora a partir de una Raspberry Pi, una radio definida por software bladeRF, dos antenas GSM y, claro, una impresora Hewlett Packard Laserjet 1320. En su sitio web se pueden consultar todos los datos del proyecto y, también, descargar el código fuente del software que controla la Stealth Cell Tower. Asimismo, también se pueden consultar allí otros interesantes proyectos de Julian.

Botón del pánico para las mujeres en la India

Smartphones en la India

Cuando el gobierno de un país tiene la obligación de llegar a estos extremos, es que algo no se está haciendo bien. Quizás vamos avanzando un pasito para adelante y dos para atrás.

Desde el 1 de enero del próximo año 2017, en la India será obligatorio que todos los teléfonos móviles vendidos, sean smartphone o no, incluyan un dispositivo de emergencia o botón del pánico como parte del esfuerzo para mejorar la seguridad de las mujeres de ese país. Esto lo ha confirmado hoy el Ministerio de Telecomunicaciones del gobierno de la república. El mandato requiere, pues, que los fabricantes de teléfonos implementen una función de emergencia que podría ser activada, por ejemplo, manteniendo presionadas la tecla numéricas del 5 o del 9 en el teclado.

Como decimos, la funcionalidad será obligatoria en todos los teléfonos desde el 1 de enero de 2017, mientras que los sistemas de navegación GPS también serán obligatorios en todos los dispositivos para el año 2018.

La seguridad de las mujeres en la India ha llamado la atención en todo el mundo tras los informes de violaciones en grupo y otras formas de violencia sexista. En el año 2014 se denunciaron más de 330.000 casos de violencia contra la mujer, según las estadísticas del gobierno, un nueve por ciento más respecto al año anterior. Este asunto ha estimulado a algunas empresas para desarrollar aplicaciones y servicios que hagan más fácil para las mujeres ponerse en contacto con los servicios de emergencia.

Todavía no está muy claro cuáles de estos servicios serán los receptores del aviso a través de la nueva función de botón del pánico, y es que la India no tiene un sistema nacional del tipo 112 europeo, sino que tiene cuatro números diferentes para distintos servicios. Aunque es posible que se produzca un cambio hacia dicho número.

La India, un país con más de 1.240 millones de habitantes, un lugar para la preocupación en cuanto a agresiones de género se refiere. Es una pena que esto suceda aún hoy en nuestro planeta.

Robando datos de ordenadores usando calor

Sistema ¿seguro?

Los sistemas informáticos aislados del exterior por técnicas de air gap no están conectados a otros sistemas ni a Internet, están aislados físicamente porque, por lo común, son equipos que demandan medidas de muy alta seguridad debido a la sensibilidad de sus datos. Se utilizan en redes militares clasificadas, redes de transacciones de crédito o en sistemas de control industrial que operan con infraestructuras críticas. Para extraer datos de estos sistemas, normalmente suele ser necesario acceder físicamente al equipo con algún medio de almacenamiento externo (o no).

Sin embargo, investigadores de seguridad en la Universidad Ben Gurion (Israel) encontraron una manera de recuperar los datos de un equipo air gap utilizando sólo las emisiones de calor de éste y una serie de sensores térmicos incorporados. El método podría permitir a los atacantes obtener subrepticiamente contraseñas o claves de seguridad de un sistema protegido y transmitirlos a otro sistema cercano conectado a Internet. Así mismo, también podrían utilizar el equipo conectado a Internet para enviar comandos maliciosos al sistema air gap con la misma técnica de calor y los sensores.

A continuación podemos ver una demostración en vídeo en la que se enseña cómo fueron capaces de enviar un comando de un ordenador a una máquina air gap adyacente para mover un juguete de lanzamiento de misiles.

El ataque de prueba de concepto requiere que ambos sistemas, antes que nada, sean comprometidos con malware. Además, en la actualidad, el ataque permite sólo ocho bits de datos que transmitir de forma fiable, y no grandes cantidades. También funciona sólo si el sistema air gap se encuentra a 40 centímetros del otro equipo de control de los atacantes. Todo ello por ahora, en un futuro dicen que las posibilidades pueden ser infinitas.

¿Y cómo funciona todo esto? Los ordenadores producen diferentes niveles de calor en función de la cantidad de procesos que estén ejecutando. Además de la CPU, el chip gráfico y otros componentes de la placa producen un calor significativo. Para controlar la temperatura, las computadoras tienen una serie de sensores térmicos incorporados que detectan fluctuaciones de calor y provocan que entre en funcionamiento un ventilador interno para enfriar el sistema cuando sea necesario o, incluso, apagarlo para evitar daños.

Este nuevo ataque, al que estos investigadores han llamado BitWhisper (algo así como el susurrador de bits), utiliza estos sensores para enviar comandos a un sistema air gap. La técnica funciona un poco como el código Morse, con el sistema de transmisión provocando aumentos controlados de calor para comunicarse con el sistema de recepción, que utiliza sus sensores térmicos integrados para detectar los cambios de temperatura y traducirlos en dígitos binarios, esto es en ceros y unos.

Precisamente en comunicar un 1 binario consiste esta demostración del vídeo de ejemplo. Los investigadores aumentaron las emisiones de calor del equipo de transmisión sólo 1 grado sobre un marco de tiempo predefinido. Después transmitieron un 0 para restaurar el sistema a la temperatura base durante otro periodo de tiempo predefinido. El equipo que recibe los bits traduce este código binario en un comando que causa la reubicación del lanzador de misiles de juguete (ello gracias al malware que hay por detrás, claro).

Los investigadores diseñaron su malware para tomar en consideración las fluctuaciones de temperatura normales de un ordenador y distinguirlas de las fluctuaciones que señalan que un sistema está tratando de comunicar. Y, aunque este malware aumenta la temperatura un único grado en señal de comunicación, un atacante podría aumentar la temperatura en cualquier cantidad, siempre y cuando sea dentro de lo razonable para evitar la creación de la sospecha que puede levantar un ventilador hiperactivo si el ordenador se sobrecalienta en exceso.

Unas gafas de realidad aumentada de hace quince años

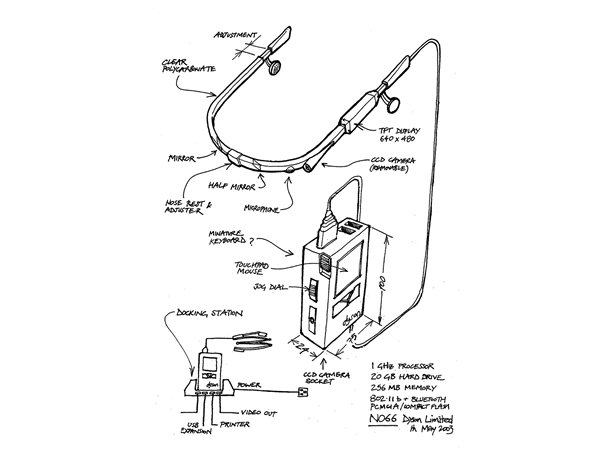

Dyson Halo

Probablemente conozcas la empresa Dyson por sus máquinas aspiradoras y sus ventiladores de aspecto futurista, pero en los veintiún años de vida que tiene esta compañía británica, Sir James Dyson ha estado inventado muchos más artículos de alta tecnología para el hogar. Sin embargo, su objeto más emblemático fue, sin duda, el casco de realidad aumentada que se parece, asombrosamente, a las Google Glass. ¡Ah, y es de hace quince años!

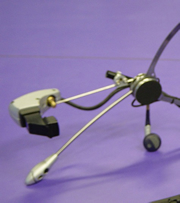

En el año 2001, Dyson comenzó a trabajar en un casco-auricular de realidad aumentada al que denominó Dyson Halo (formalmente «Proyecto NO66«). El Halo estaba destinado a ser un ordenador portátil, montado en la cabeza del usuario, que parecía un par de gafas y respondía a mensajes de audio. ¿Te suena familiar?

El prototipo de Halo es una mezcla entre las Google Glass y un walkman noventero. De hecho, con su banda de metal delgada y maraña de cables, el dispositivo es claramente un producto de los años cercanos al 2000. Y es que cuando Dyson estaba construyendo Halo, carecía de la miniaturización de la tecnología y el brillo estético que, más de una década de investigación y desarrollo añadido, proporcionaron los ingenieros a las Google Glass, pero su meta como un ordenador personal portátil fue sorprendentemente similar.

Dyson Halo

En la versión de Dyson, un auricular con patillas de gafas se conecta a un ordenador rectangular lo suficientemente pequeño para llevarlo en el bolsillo. Piénsese en ello como un computador portátil, del tamaño de una tarjeta, con una pantalla translúcida proyectada sobre un prisma que se coloca a escasos milímetros de los ojos.

El equipo fue construido para utilizar aplicaciones similares a las que vemos ahora en los teléfonos inteligentes y podía ser controlado de un par de maneras: un dispositivo de pulsera (¡hola, smartwatch!) hacía las veces de ratón, lo que permitía al usuario controlar el cursor virtual en la pantalla; además, también se podía manejar a base de órdenes habladas, mientras que un asistente personal virtual (¿Siri, Cortana, Google Now, estáis ahí?) servía para leer los correos electrónicos y realizar tareas básicas.

Esquema de Halo

¿Una dosis de tecnología con déjà vu, o tal vez sólo un ejemplo de una buena idea antes de tiempo? Los ingenieros de Dyson pasaron tres años trabajando en Halo, pero al final lo dejaron de lado para centrarse en conseguir otros productos para el mercado doméstico.

Dyson disponía de otros inventos que nunca llegaron al mercado, aunque estos eran más prácticos y menos intrigantes que Halo, como filtros para motores diésel o motores de hidrógeno y oxígeno. Al igual que Halo, ninguna de estas ideas llegó a buen término. Pero Dyson no los cuenta como fracasos, más bien son sólo algunas de las muchas exploraciones tecnológicas que podrían llegar a ser, algún día, una gran ayuda para un nuevo producto.

¿Por qué una tecnología de hace 40 años sigue controlando el tráfico aéreo estadounidense?

FAA

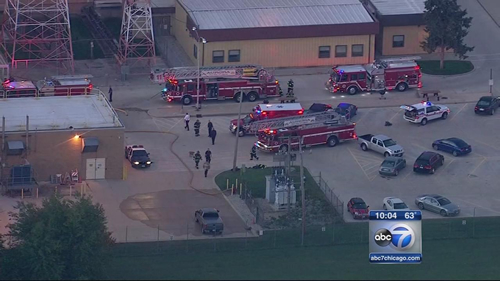

El 26 de septiembre del año 2014, un contratista del mundo de las telecomunicaciones llamado Brian Howard despertó temprano y se dirigió al Chicago Center, un centro de control de tráfico aéreo en Aurora (Illinois) donde había trabajado durante ocho años. Había decidido suicidarse y, como gesto de su última voluntad, planeó llevarse un pedazo del sistema del control de tráfico aéreo de Estados Unidos con él.

Las grabaciones confirmaron que Brian Howard entró en el Chicago Center a las 5:06 de la mañana y bajó al sótano, donde provocó un incendio en el compartimento de electrónica. Seguidamente se cortó el cuello. Los servicios médicos salvaron la vida de Howard, pero los sistemas del Chicago Center, que en ese momento controlaba el tráfico aéreo por encima de 10.000 pies y en un área de 91.000 kilómetros cuadrados, se apagaron.

El día del incendio

Las aerolíneas cancelaron 6.600 vuelos; el tráfico aéreo se interrumpió durante 17 días. Howard había querido causar problemas, pero no había previsto una catástrofe de tal magnitud. Había publicado un mensaje en su cuenta de Facebook diciendo que el sabotaje «no tendría un alto costo para el sistema de control del espacio aéreo, pues todas las comunicaciones deberían cambiar a la ubicación alternativa«. Se equivocaba. Nadie sabe de qué lugar alternativo estaba Howard hablando, porque no existe tal cosa. Howard había trabajado en el centro durante casi una década, e incluso él no conocía eso.

En cualquier momento dado, alrededor de 7.000 aviones sobrevuelan los Estados Unidos. Durante los últimos 40 años, el mismo sistema informático ha controlado todo este tráfico de gran altitud, es una reliquia de la década de 1970 conocida como Host. El núcleo del sistema es anterior a la llegada del GPS, por lo que Host utiliza radares terrestres punto a punto. Cada día, miles de viajeros aéreos ponen sus teléfonos inteligentes con GPS en «modo avión», mientras que sus vuelos son guiados por una tecnología que es anterior al ‘Speak & Spell‘ de Texas Instruments.

Si ahora mismo estás leyendo esto a 30.000 pies de altura, relájate, Host es todavía seguro en términos de conducir aviones de un punto A a un punto B, pero es increíblemente ineficiente. Puede manejar una cantidad limitada de tráfico, y los controladores no pueden ver nada fuera de su propio espacio aéreo; cuando un avión se traslada a un espacio aéreo contiguo, se desvanece en su radar.

La FAA (Federal Aviation Administration) estadounidense sabe todo esto perfectamente. Durante once años, la agencia ha ido migrando hacia un conjunto de actualizaciones conocidas como NextGen. En su núcleo porta un nuevo sistema informático que reemplazará a Host y permitirá que cualquier controlador, en cualquier lugar, pueda ver cualquier avión en el espacio aéreo estadounidense. En teoría, esto permitiría a un centro de control aéreo asumir el mando de otro con sólo tocar una tecla, como Howard parecía creer que ya era posible.

Esta tecnología es problemática y costosa, pero esa no es la mayor de las complicaciones. El problema principal es que NextGen es un proyecto de la FAA. La agencia es, principalmente, un órgano regulador, es la responsable de mantener la seguridad del espacio aéreo nacional y, además, también se encarga de operar el control del tráfico aéreo, un conflicto inherente que causa grandes problemas a la hora de completar las actualizaciones. Modernización, una lucha de cualquier agencia federal, es prácticamente la antítesis de la cultura operativa de la FAA, que es adversa al riesgo metódico y burocrático. A esto se suma que la FAA es la única consumidora del producto, por lo que no existen presiones por parte de los mercados.

La primera fase de NextGen es reemplazar Host con el nuevo sistema informático, la base para todas las futuras actualizaciones. La FAA pretendía terminar el trabajo para la pasada primavera, cinco años más tarde de lo previsto y, por lo menos, 500 millones de dólares por encima del presupuesto original.

La compañía Lockheed Martin comenzó a desarrollar el software en el año 2002, y la FAA proyectó que la transición desde Host estaría completa a finales de 2010. En 2007, el sistema actualizado se utilizaba sólo a través de pruebas internas, pero una vez instalado, era espantosamente inestable y contenía cientos de bugs. Por ejemplo, a veces vinculaba aviones a los datos de vuelo de una aeronave equivocada; otras veces los aviones desaparecían por completo de las pantallas de los controladores.

Recientemente, en abril de 2014, el sistema se vino abajo en Los Angeles Center cuando un jet militar U-2 entró en su espacio aéreo. El avión espía cruzó a 60.000 pies, el doble de la altitud de los aviones comerciales, y su plan de vuelo provocó un fallo de software que sobrecargó la sistema y lo tumbó.

En el sector privado, las empresas de tecnología se mueven rápido y actualizan sistemas sin poner en riesgo nuestra seguridad. Pero cuando el gobierno actualiza sus tecnologías, las regulaciones y la burocracia interceden antes de escribir una sola línea de código. El proceso de contratación pública está atada a mil reglas y normas, y la nueva tecnología en cuestión tiene que ajustarse a esas normas, si son o no son eficientes ni siquiera es relevante.

Y en esas estamos.